Полная версия

Человеко-ориентированный искусственный интеллект: UX, аналитика, этика

– Центром взаимодействия стал экран – визуальная плоскость управления.

GUI впервые поставил пользователя в центр проектирования. Машина стала адаптироваться к человеку – через метафору, визуальный язык, интерактивность.

III. Touch и Mobile-first интерфейсы (2007—н.в.)

Характеристики:

– Сенсорный ввод, жесты, отсутствие традиционного курсора;

– Экран = интерфейс; ограниченное пространство, контекстность;

– Взаимодействие в движении, с одной рукой, в социальных ситуациях.

Восприятие пользователя:

– Пользователь ожидает интуитивности и мгновенного отклика;

– Интерфейс воспринимается как «естественный» – нет барьеров мышления;

– Повышенная чувствительность к задержке, точности, реактивности.

Дизайнерские задачи:

– Создание минималистичных, адаптивных интерфейсов с высокой плотностью смысла;

– Учет физиологических и социальных ограничений: размер пальца, освещение, отвлекающие факторы;

– Разработка UX-паттернов, адаптированных под касание (tap targets, gestures).

Мобильные интерфейсы усилили контекстное взаимодействие – пользователь ждёт, что система «понимает», где он, когда, с каким намерением и в каком состоянии.

IV. Conversational UI – голосовые и чат-интерфейсы (2015—н.в.)

Характеристики:

– Взаимодействие через диалог: голосом или текстом;

– Отказ от традиционной визуальной навигации;

– Сильная зависимость от NLP и диалоговой логики.

Восприятие пользователя:

– Система воспринимается как собеседник, а не как программа;

– Возникает иллюзия агентности: «у ИИ есть намерения»;

– Повышенное ожидание эмоциональной и контекстной адекватности.

Дизайнерские задачи:

– Проектирование сценариев, интентов, ответов, тона и логики общения;

– Учет вариативности языка, синтаксиса, ошибок пользователя;

– Работа с ожиданиями: «ИИ понимает меня» – «ИИ отвечает правильно».

Conversational UI требует когнитивного моделирования поведения ИИ, а не просто навигации по функциям. Пользователь ждёт эмпатии, адаптивности, персонализации.

V. AI-driven UX – интеллектуальные адаптивные интерфейсы (2020+)

Характеристики:

– ИИ определяет содержание, структуру, логику интерфейса в реальном времени;

– Система обучается на действиях пользователя, строит прогнозы, адаптирует поведение;

– Пример: рекомендательные системы, персонализированные интерфейсы, умные ассистенты.

Восприятие пользователя:

– Пользователь всё чаще не понимает, почему система ведёт себя определённым образом;

– Возникает ощущение автономности – система действует «сама»;

– Повышаются риски когнитивного дискомфорта, недоверия, выученной беспомощности.

Дизайнерские задачи:

– Не просто проектировать интерфейс, а проектировать поведение ИИ;

– Внедрять объяснимость, визуализацию логики, доверительные механизмы;

– Создавать петлю обратной связи: пользователь влияет на систему, система объясняет себя.

AI-driven UX требует перехода от дизайна интерфейса к архитектуре взаимодействия с интеллектуальной системой. Это уже не интерфейс в классическом смысле – это проектирование цифрового поведения.

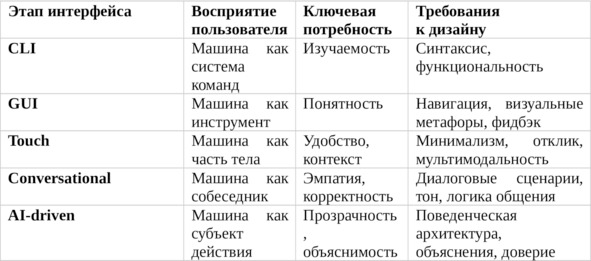

Как каждый этап изменил восприятие и требования к дизайну

Эволюция интерфейсов – это не просто изменение формы взаимодействия. Это постепенное усложнение роли системы в когнитивной экосистеме пользователя. От инструмента – к посреднику. От визуального слоя – к цифровому поведению. От кнопок – к рекомендациям. И вместе с этим меняется сам UX: от юзабилити к доверительному, прозрачному и контекстному взаимодействию, где ИИ не просто делает, а объясняет, адаптируется, слушает и учитывает человека.

Именно здесь начинается зона ответственности HCAI – следующей стадии в развитии взаимодействия. Не дизайна кнопок, а дизайна отношений между человеком и интеллектуальной системой.

Зачем нужен HCAI: от автоматизации к осмысленному взаимодействию

По мере того, как искусственный интеллект становится активным элементом пользовательского опыта, сама суть взаимодействия между человеком и системой меняется. ИИ больше не просто технический компонент, обрабатывающий данные на заднем плане. Он становится медиатором реальности – предлагает, фильтрует, оценивает, принимает решения, заменяет выбор. Это приводит к сдвигу в роли интерфейса: если ранее интерфейс «открывал» функции, то теперь он становится точкой входа в логику поведения автономной системы. Именно в этом контексте возникает необходимость в человеко-ориентированном подходе к ИИ – HCAI.

ИИ без человека: пример алгоритмов TikTok и YouTube

Алгоритмические рекомендательные системы – одна из самых масштабных и заметных форм внедрения ИИ в повседневную жизнь. Алгоритм YouTube, как и TikTok For You Feed, строится на непрерывном сборе и анализе пользовательских сигналов: история просмотров, продолжительность просмотра, лайки, пропуски, повторы. Модель обучается на миллиардах взаимодействий и формирует персонализированную ленту рекомендаций, оптимизированную под удержание внимания.

Формально система достигает поставленной метрики – максимизации вовлечённости. Но при этом у пользователя отсутствует возможность:

– понять, почему он видит тот или иной контент;

– изменить принципы работы рекомендации;

– отключить или корректно перенацелить поведенческий профиль.

В результате пользователь теряет ощущение контроля. Контент кажется «навязанным», а поведение системы – непрозрачным. Это приводит к недоверию, усталости, ощущению цифрового давления, особенно в случаях, когда система фиксирует кратковременные сигналы (например, случайный клик на тревожное видео) и превращает их в устойчивый паттерн рекомендаций.

В случае TikTok это особенно заметно: поведенческий профиль формируется за считанные минуты, но не объясняется, не визуализируется, не редактируется. Алгоритм работает «через пользователя», но без диалога с ним.

Почему автоматизация без обратной связи – это риск

Автоматизация становится опасной тогда, когда она отменяет обратную связь. В классической HCI обратная связь (feedback) – один из базовых принципов юзабилити: пользователь должен видеть, что произошло после действия. В AI-системах это правило часто нарушается: поведение модели адаптивно, но не сопровождается комментариями, не подлежит корректировке, не даёт возможности объяснить логику вывода.

Когда пользователь не понимает, как повлиять на поведение системы – он либо прекращает использовать её, либо теряет доверие, считая модель манипулятивной или «живущей своей жизнью».

Пример из UX-аналитики: пользователи умных колонок с голосовыми ассистентами (Siri, Google Assistant) часто перестают использовать функции, если первые 1—2 взаимодействия приводят к неадекватным или непонятным результатам. Причина – отсутствие объяснения ошибок, непрозрачность «мысленного процесса» ИИ и невозможность корректировки запроса.

Роль UX и поведенческой аналитики в предотвращении проблем

HCAI строится на признании того, что поведение системы должно проектироваться с учётом восприятия, эмоций, ожиданий и реакций пользователя. UX в этом контексте – не визуальный слой, а когнитивная инфраструктура: через неё человек осмысливает, прогнозирует и влияет на поведение ИИ.

Поведенческая аналитика в HCAI отвечает за:

– сбор данных об эмоциях, вовлечённости, фрустрации, уровне доверия;

– интерпретацию паттернов поведения: что пользователь делает, чего избегает, что вызывает тревожность;

– формирование метрик доверия и прозрачности, а не только эффективности (например: perceived control, cognitive effort, satisfaction with agency).

Используя эти данные, можно корректировать поведение моделей: не только улучшать метрики CTR, но и снижать психологическое сопротивление, увеличивать понимание и формировать чувство контроля у пользователя.

Этика, доверие и инклюзия как проектные параметры

Когда система ИИ вступает в контакт с человеком, она не может быть нейтральной. Любая модель обучается на данных, которые отражают реальные искажения: социальные, поведенческие, экономические. В результате:

– алгоритм может непреднамеренно усиливать дискриминацию;

– недоверие может возрастать у маргинализированных групп, которые не распознают себя в логике модели;

– система может оказаться недоступной по когнитивным, языковым или физическим причинам.

Инклюзивность, справедливость и прозрачность в HCAI – не абстрактные ценности, а функциональные свойства системы, от которых зависит принятие технологии обществом.

Например, в образовательных системах ИИ, предлагающих персонализированные рекомендации студентам, крайне важно:

– объяснять, почему предложен тот или иной трек;

– учитывать индивидуальные стили обучения;

– не усиливать предвзятости, связанные с оценками или демографией;

– предоставлять инструменты для изменения траектории.

Эти требования не входят в «техническое ТЗ» модели. Они возникают на уровне взаимодействия – и именно UX и поведенческая аналитика HCAI обеспечивают их реализацию.

HCAI – это не про «удобство»

Одно из ключевых недоразумений при интерпретации HCAI – это сведение его к теме удобства использования (usability). Хотя юзабилити остаётся важной частью взаимодействия, в центр HCAI ставится не удобство, а осмысленность, безопасность и адаптивность системы.

Удобство – это локальная характеристика: легко ли совершить действие.

Адаптивность и прозрачность – это системные свойства:

1. насколько система поддерживает пользователя в достижении целей,

2. насколько она корректно реагирует на изменения контекста,

3. может ли человек сохранять автономию, когда система берёт инициативу.

Долговременное взаимодействие возможно только тогда, когда ИИ не отнимает у человека право на интерпретацию и участие, а помогает ему лучше понять ситуацию, расширить выбор и сохранить чувство субъектности.

ключевые термины главы 1

Human-Computer Interaction (HCI) – Область, изучающая проектирование и оценку взаимодействия между человеком и компьютерными системами с целью повышения удобства, эффективности и понятности.

Human-Centered AI (HCAI) – Подход к разработке систем ИИ, фокусирующийся на прозрачности, объяснимости, контролируемости, доверии и социальной ответственности перед пользователем.

CLI (Command Line Interface) – Тип интерфейса, в котором взаимодействие происходит через ввод текстовых команд. Требует знания синтаксиса и логики командной оболочки.

GUI (Graphical User Interface) – Интерфейс с графическими элементами (окна, кнопки, иконки), делающий взаимодействие визуальным и более доступным.

Touch Interface – Сенсорный интерфейс, использующий жесты и касания, особенно распространённый в мобильных устройствах.

Conversational UI – Интерфейсы, основанные на диалоге с пользователем – текстовом или голосовом, часто с применением NLP.

AI-driven UX – Пользовательский опыт, управляемый ИИ – адаптивный, персонализированный, формируемый с помощью обучаемых моделей.

Usability – Показатель удобства системы: насколько она проста в освоении, эффективна в использовании и удовлетворяет потребности пользователя.

User Experience (UX) – Совокупность восприятий, реакций, эмоций и поведенческих паттернов пользователя при взаимодействии с системой.

Cognitive Load – Объём умственных усилий, который человек тратит на выполнение задачи или понимание интерфейса.

Explainability (XAI) – Способность ИИ-системы объяснить логику своих решений так, чтобы это было понятно человеку.

Transparency – Степень открытости алгоритма и интерфейса: насколько пользователь может понять, как работает система.

Bias (Алгоритмическая предвзятость) – Непреднамеренное смещение или дискриминация в алгоритмах, возникающие из-за перекосов в данных или структуре модели.

Fairness – Принцип справедливости: система должна принимать решения, не нарушая равенство возможностей между пользователями.

Ментальная модель – Внутреннее представление пользователя о том, как работает система. Чем ближе она к реальной логике – тем лучше UX.

Gulf of Execution / Evaluation – Расстояние между намерением пользователя и возможностями интерфейса (execution) и между результатом и его интерпретацией (evaluation), согласно модели Нормана.

Trust – Уверенность пользователя в корректной, честной и предсказуемой работе системы ИИ.

Controllability – Возможность пользователя влиять на поведение ИИ, отменять или уточнять его действия.

Responsibility-by-Design – Подход, при котором принципы ответственности, прозрачности и объяснимости закладываются на этапе проектирования, а не «добавляются» постфактум.

Agency (агентность) – Способность пользователя действовать осознанно и автономно при взаимодействии с системой. В HCAI задача – её сохранить.

Behavioral Pattern – Поведенческий шаблон, отражающий типичную реакцию или выбор пользователя в определённой ситуации.

Adaptive System – Система, которая подстраивается под пользователя на основе данных, поведения или внешнего контекста.

Глава 2. Психология пользователя в HCAI

Когнитивные основы пользовательского взаимодействия с интеллектуальными системами

Проектирование взаимодействия между человеком и системой – это не только вопрос интерфейса, визуальной эстетики или структуры сценариев. Взаимодействие с ИИ задействует ключевые когнитивные механизмы: восприятие, внимание, кратковременную и долговременную память, а также процессы интерпретации и принятия решений. Если эти механизмы не учитываются, система может быть технически корректной, но когнитивно – избыточной, перегруженной, непонятной. В контексте HCAI этот вопрос становится особенно критичным: ИИ-системы не просто реагируют, они инициируют действия, прогнозируют, предлагают, управляют контекстом. А значит, они вступают в прямое взаимодействие с ментальными процессами пользователя.

Когнитивная нагрузка: ресурсный предел мышления

Когнитивная нагрузка (cognitive load) – это объём ментальных ресурсов, который требуется человеку для обработки информации, принятия решения или выполнения действия. Этот термин был введён в рамках когнитивной психологии и педагогики (Sweller, 1988), но быстро стал центральным понятием в UX-дизайне.

Когнитивная нагрузка возникает всегда, когда:

– интерфейс требует усилий для навигации;

– система предлагает несколько опций без явной иерархии;

– результат действия неясен, и требуется дополнительное мышление для интерпретации;

– отсутствует прямая связь между целью и способом её достижения.

Для ИИ-интерфейсов характерны особые источники когнитивной нагрузки:

1. Обилие вероятностных выводов без явных оснований.

2. Персонализация без объяснения принципов.

3. Автоматизация, не отражённая визуально или логически.

4. Скрытая адаптация, создающая ощущение нестабильности.

Если пользователь не может удерживать в кратковременной памяти текущие действия, правила, логику поведения системы – возникает фрустрация. Особенно опасна когнитивная перегрузка, при которой пользователь теряет способность принимать рациональные решения, ориентироваться в интерфейсе и, в конечном итоге, отказывается от взаимодействия.

UX-задача HCAI в этом контексте – минимизировать когнитивную нагрузку без потери функциональной мощности системы. Это достигается через понятные сценарии, иерархию информации, визуальное подтверждение действия, использование ментальных моделей пользователя и поддержку кратковременной памяти.

Внимание: распределение ресурсов в условиях перегрузки

Внимание – это ограниченный когнитивный ресурс, распределяемый между стимуляцией, задачами и источниками информации. В условиях ИИ-взаимодействия внимание становится критически важным, потому что:

– интеллектуальная система может инициировать действия без запроса;

– интерфейс может меняться динамически в зависимости от поведения пользователя;

– рекомендации могут конкурировать за внимание (например, push-уведомления, адаптивные блоки контента).

Психология внимания указывает на несколько свойств, актуальных для HCAI:

– избирательность: пользователь замечает только то, что имеет когнитивную значимость;

– ограниченность: невозможно удерживать внимание более чем на 4—7 элементах одновременно;

– подверженность искажению: внимание легко переключается на яркие, а не важные элементы.

ИИ-системы, действующие вне визуального контекста (например, голосовые помощники или автоматические триггеры), особенно рискуют нарушить восприятие внимания, потому что пользователь не ожидает действия, и не получает предупреждающего сигнала.

В UX-дизайне HCAI это требует строгого внимания к темпу, плотности и каналам подачи информации. Архитектура интерфейса должна поддерживать фокус, а не разрушать его.

Восприятие: преобразование интерфейса в смысл

Восприятие – это процесс преобразования сенсорных данных в осмысленные структуры. В UX этот процесс охватывает зрительные, звуковые, тактильные и временные характеристики интерфейса.

Особенности восприятия, критичные для HCAI:

Гештальт-принципы – пользователь группирует элементы по сходству, близости, симметрии.

Иллюзия причинности – человек склонен воспринимать последовательные события как связанные, даже если это не так.

Аффективное восприятие – эмоциональный отклик влияет на интерпретацию поведения системы.

ИИ-интерфейсы могут нарушать принципы восприятия следующим образом:

– изменяя поведение без видимых причин (например, адаптивный рейтинг);

– создавая иллюзию персонализированного понимания, в то время как это шаблон;

– скрывая внутренние связи между входными и выходными данными.

Если пользователь не может сопоставить стимул и результат, восприятие дезорганизуется. Он начинает чувствовать тревожность, раздражение или отрешённость. Особенно чувствительны к таким ошибкам пользователи с разной сенсорной или когнитивной доступностью: слабое зрение, сниженная концентрация, возрастные особенности.

В HCAI восприятие должно проектироваться как структура устойчивых, воспроизводимых смыслов, а не как реактивная визуализация. Это достигается через повторяемость, семиотику (иконы, цвета, формы), а также поясняющие микросценарии.

Память: ограничения и якоря взаимодействия

Кратковременная память (short-term memory) ограничена по объёму: согласно исследованиям Миллера, человек может удерживать от 5 до 9 единиц информации одновременно (магическое число 7 ± 2). При этом длительность хранения – около 15—30 секунд без повторения. В условиях цифрового взаимодействия это означает, что:

– пользователю сложно удерживать в памяти структуру диалога, особенно если он разветвлён;

– без визуальной поддержки или напоминания прошлые действия забываются;

– интерфейсы с несколькими вкладками, состояниями, вариантами вызывают когнитивную фрагментацию.

ИИ-системы добавляют сложности: адаптивность, нестабильность, вариативность. Если пользователь не получает подтверждения действий или напоминания о предыдущем шаге, память обрывается, и возникает эффект «перезапуска» – каждый новый экран ощущается как первый.

В HCAI необходимо:

– сохранять контекст: указывать, где находится пользователь и что уже было сделано;

– использовать прогресс-бары, чек-листы, breadcrumb-навигацию;

– напоминать пользователю об его собственных действиях (например: «Вы уже искали X»);

– минимизировать временные разрывы в логике.

Долговременная память (long-term memory) зависит от повторений, смысловых связей и эмоционального отклика. Поэтому особенно важны консистентность, повторяемость и поддержка мотивации в UX HCAI.

Модели принятия решений: рациональные и ограниченно-рациональные (Kahneman, Tversky)

Любое взаимодействие человека с системой – это не просто реакция на стимул, а серия микрорешений. Открыть приложение, нажать кнопку, принять рекомендацию ИИ, игнорировать уведомление, отказаться от действия – каждое из этих событий включает когнитивный акт выбора. Понимание того, как человек принимает решения в условиях неопределённости, ограниченного времени и информационной перегрузки, позволяет проектировать ИИ-системы, которые не только удобны, но и не искажают поведение, не манипулируют восприятием и не подрывают автономию пользователя.

HCAI опирается на модели поведенческой экономики и когнитивной психологии, в частности – на исследования Даниэля Канемана и Амоса Тверски, чьи работы заложили основу понимания того, как реальные люди принимают решения – не в идеальных условиях, а в сложной, эмоционально и когнитивно насыщенной среде.

Рациональная модель: Homo Economicus

В классических экономических и инженерных теориях долгое время доминировала модель рационального агента, или Homo Economicus. Согласно этой модели:

– человек принимает решения, стремясь максимизировать свою полезность;

– обладает полной информацией о вариантах;

– способен обрабатывать все альтернативы;

– действует логично и последовательно.

Применительно к интерфейсу это предполагало, что если система предложит пользователю наилучший выбор, тот его примет – при условии, что информация полная и подана ясно.

Однако многократно доказано, что в реальной жизни люди не действуют рационально:

– они не видят всех опций;

– не могут оценить вероятности;

– опираются на эвристики, интуицию, эмоции;

– искажают информацию и переоценивают риски.

Таким образом, рациональная модель – удобный, но неверный ориентир для проектирования ИИ-взаимодействия.

Ограниченная рациональность (bounded rationality): Г. Саймон

Герберт Саймон (H. Simon), один из первых критиков классической рациональности, ввёл понятие ограниченной рациональности. В его модели человек:

– стремится к приемлемому, а не к оптимальному решению (satisficing);

– работает с ограниченными когнитивными ресурсами;

– часто выбирает первое «достаточно хорошее» решение, а не лучшее из всех.

Для UX-дизайна это означает, что интерфейс должен:

1. снижать нагрузку на анализ;

2. предлагать адекватные подсказки и ориентиры;

3. помогать не в выборе, а в отказе от плохих вариантов.

ИИ в этом контексте должен не только подсказывать, но и учитывать, как именно пользователь принимает решения в условиях недостатка информации, времени и уверенности.

Эвристики и искажения (biases): Канеман и Тверски

Канеман и Тверски радикализировали представление о человеческом мышлении. Их модель двухсистемного мышления (двухсистемная модель – dual-system theory) предполагает существование:

– Система 1 – быстрое, автоматическое, эмоциональное мышление

– Система 2 – медленное, логическое, аналитическое мышление

Большинство пользовательских решений – особенно в цифровой среде – принимаются Системой 1, то есть интуитивно, под влиянием настроения, паттернов, первого впечатления.

Примеры типичных когнитивных искажений:

1. Эффект якоря (anchoring) – первая цифра или значение влияет на последующие оценки.

2. Эвристика доступности – пользователь оценивает вероятность события по тому, насколько легко он вспоминает подобный случай.

3. Иллюзия контроля – человек переоценивает своё влияние на случайные процессы.

4. Слепое следование рекомендациям (automation bias) – доверие машине выше, чем собственным суждениям, даже при наличии ошибок.