Полная версия

Человеко-ориентированный искусственный интеллект: UX, аналитика, этика

Человеко-ориентированный искусственный интеллект: UX, аналитика, этика

Юлия Владимировна Вересова

© Юлия Владимировна Вересова, 2025

ISBN 978-5-0067-6401-9

Создано в интеллектуальной издательской системе Ridero

Сведения об авторе

Юлия Вересова – исследователь в области HCAI, поведенческой аналитики и проектирования взаимодействия человека и ИИ.

Профессиональные интересы включают разработку адаптивных ИИ-интерфейсов, построение этически устойчивых цифровых сред, исследование когнитивных и эмоциональных механизмов взаимодействия с интеллектуальными системами, а также создание моделей пользовательского поведения в условиях автоматизации и генеративного ИИ.

Предисловие

Книга посвящена основам и прикладным аспектам Human-Centered Artificial Intelligence (HCAI). Цель книги – сформировать у читателя целостное понимание принципов HCAI и подготовить его к осознанной работе в сфере проектирования, оценки и сопровождения интеллектуальных систем.

Материалы структурированы по модулям и соответствуют академической логике изучения предмета в формате учебного курса. Каждый раздел включает теоретическую основу, методические подходы, практические акценты и глоссарий ключевых терминов. Отдельное внимание уделено таким аспектам, как объяснимость моделей, доверие к ИИ, когнитивная нагрузка, пользовательские исследования в AI-интерфейсах, юридические нормы и анти-паттерны UX в интеллектуальных продуктах.

Книга ориентирована на UX-исследователей, аналитиков, дизайнеров взаимодействия, разработчиков ИИ-систем, преподавателей и студентов старших курсов. Она может быть полезна как для самостоятельного изучения, так и в рамках образовательных программ по HCAI, цифровой этике, взаимодействию человек—технологии и гуманитарным аспектам искусственного интеллекта.

Примечание: В тексте упоминаются организации, деятельность которых запрещена на территории РФ.

Глава 1. Введение в человеко-ориентированный ИИ (HCAI)

Почему недостаточно просто «разработать ИИ»

На протяжении многих десятилетий развитие искусственного интеллекта рассматривалось в первую очередь как инженерная задача. Исследования концентрировались на алгоритмах, моделях, вычислительной эффективности, способности систем к обучению и обобщению. Главной метрикой «успеха» считалась точность модели, измеряемая на тестовой выборке. В рамках такой парадигмы предполагалось, что если система демонстрирует высокий уровень точности или классификационной силы, то она по определению полезна, применима и эффективна. Однако с развитием практического применения ИИ, особенно в пользовательских и социально чувствительных сферах – от медицины до образования и социальных сетей – стало очевидно, что алгоритмическая эффективность не гарантирует качество взаимодействия с человеком.

Иными словами, разработать работающий ИИ – это необходимое, но не достаточное условие создания полезной, безопасной и этичной интеллектуальной системы.

I. Алгоритмическая корректность ≠ пользовательская приемлемость

Интеллектуальная система может формально выполнять задачу, но оставаться для пользователя:

– непонятной – её поведение будет казаться случайным или не поддающимся объяснению;

– непредсказуемой – человек не сможет интерпретировать, когда и как сработает тот или иной механизм;

– неконтролируемой – пользователь не ощущает возможности влиять на результат или отменить решение;

– неприемлемой – модель может воспроизводить или усиливать дискриминационные паттерны, даже если это отражает «реальные» данные.

Типичный пример – алгоритмы рекомендаций, применяемые в социальных сетях или маркетплейсах. Даже если они эффективно повышают engagement и кликабельность, пользователь может чувствовать тревожность, потерю контроля, снижение автономии принятия решений, что приводит к эмоциональному выгоранию и цифровому отторжению.

II. Проблема ментальной модели и когнитивного разрыва

Одной из важнейших проблем взаимодействия человека с ИИ является несоответствие между реальной логикой работы модели и ментальной моделью пользователя – то есть тем, как человек думает, что система работает. Если пользователь не может предсказать поведение системы или объяснить себе её действия, возникает ощущение хаоса и фрустрации. Такое состояние известно в когнитивной психологии как когнитивный разрыв (cognitive dissonance или breakdown of sensemaking).

Когнитивные модели взаимодействия, начиная с концепций Дональда Нормана (Norman, 1986), подчеркивают важность предсказуемости и объяснимости интерфейсов. Когда же в системе действует обучаемая модель, поведение которой зависит от скрытых признаков, распределений и вероятностных предсказаний, пользователь оказывается в ситуации, где интерфейс видим, а логика – нет.

Таким образом, ИИ может функционировать «правильно» по техническим критериям, но быть непригодным для реального пользователя без поддержки когнитивной прозрачности.

III. Игнорирование этики, эмоций и восприятия

Системы, разработанные без учёта эмоциональных реакций, поведенческих паттернов, социальной справедливости или культурных особенностей, могут приводить к последствиям, несовместимым с этическими и правовыми нормами.

Так, система автоматического распределения социальных пособий, внедрённая в Нидерландах в 2019 году, использовала ИИ для прогнозирования вероятности мошенничества на основе демографических и поведенческих признаков. Модель была «эффективна», но нарушала принцип справедливости, поскольку дискриминировала по происхождению, району проживания и типу семьи. В итоге программа была отменена, а правительство принесло официальные извинения.

Этот кейс наглядно показывает, что формально корректная работа ИИ может нарушать базовые принципы прав человека, если не учитывать контекст взаимодействия, восприятие пользователя и социальную ответственность.

IV. Автоматизация без дизайна взаимодействия = потеря контроля

Во многих системах с ИИ наблюдается тенденция к «скрытой автоматизации» – то есть переходу от явно управляемых пользователем интерфейсов к системам, в которых алгоритмы принимают решения автономно и без объяснений. Такие интерфейсы уменьшают участие человека, но одновременно снижают доверие и разрушают пользовательскую агентность – ощущение, что человек способен действовать осознанно и по собственной инициативе.

Иными словами, автоматизация без сопровождения объяснений, обратной связи, возможности редактирования или отмены приводит к ощущению отчуждённости: пользователь становится пассивным наблюдателем, а не участником процесса.

V. Неразвитость UX-слоя в AI-системах как системная проблема

Большинство ИИ-платформ разрабатываются техническими командами, сфокусированными на точности моделей и производительности. В результате:

UX-дизайн внедряется на финальных этапах, в виде интерфейсной «обёртки»;

Обратная связь от пользователя не включена в петлю обучения модели;

Оценка качества ограничивается метриками (F1, precision, recall), не учитывающими восприятие и интерпретируемость;

Поведенческая аналитика воспринимается как второстепенная.

Это приводит к парадоксам: технологически сложные системы оказываются недоступными, тревожными или неприемлемыми для пользователей. Даже при наличии ресурсоёмких архитектур, дорогостоящих моделей и технической реализации, продукт может провалиться из-за отсутствия понимания человеческого фактора.

Сегодняшний этап развития ИИ требует не только прорывов в моделировании, но и переноса центра внимания с алгоритма на взаимодействие. Human-Centered AI (HCAI) предлагает фундаментальный сдвиг:

– от архитектур к контексту использования,

– от точности к объяснимости,

– от автономии к контролю,

– от поведения машины к переживанию человека.

Это не отказ от ИИ, а интеграция его возможностей в структуру человеческой деятельности – осмысленно, прозрачно и безопасно. Только при таком подходе интеллектуальные технологии смогут не просто работать, а быть принятыми, понятными и полезными в повседневной жизни.

Нарушенное доверие как следствие ошибок взаимодействия

Один из фундаментальных ресурсов, на которых строится успешное использование интеллектуальных систем, – это доверие пользователя. В отличие от традиционных программных продуктов, в которых поведение системы строго детерминировано и предсказуемо, искусственный интеллект действует в условиях неопределённости: он обучается на данных, принимает вероятностные решения, и его поведение может меняться в зависимости от контекста, новых входных данных или даже обновлений модели. Это делает взаимодействие с ИИ принципиально более хрупким: как только пользователь сталкивается с решением, которое он не может объяснить, обоснованно интерпретировать или предсказать, он начинает терять уверенность в системе.

Доверие формируется не на основании технической корректности, а через восприятие. Пользователь ожидает, что система будет действовать понятно, справедливо, логично и – при необходимости – под его контролем. Когда интерфейс не объясняет, почему была сделана та или иная рекомендация, или когда система действует вопреки ожиданиям пользователя, происходит нарушение ментальной модели взаимодействия. Человек ощущает, что ИИ ведёт себя «сам по себе», игнорирует его намерения и контекст. Это приводит к тому, что система воспринимается как неконтролируемая, а в ряде случаев – как враждебная.

Типичный пример – рекомендательные алгоритмы. Пользователь заходит в приложение, чтобы получить один тип контента, а система на основе истории поведения начинает навязчиво продвигать другую тему. С точки зрения модели – всё логично: вероятностный прогноз построен, система «учится». Но для человека это выглядит как вторжение или непонятное навязывание. Возникает ощущение: «меня не слышат», «мне не объясняют», «я не понимаю, что происходит». Даже при технически корректной работе модели теряется ощущение безопасности и управляемости – критически важные элементы доверия.

Особое внимание заслуживает поведение систем в ситуациях с высоким уровнем stakes – когда от решения зависят здоровье, финансы или личная информация. Например, если медицинская ИИ-система предлагает план лечения, не сопровождая это объяснением, пациент или врач могут отказаться от её использования. Точно так же, если финансовый алгоритм отклоняет заявку на кредит без понятного комментария, клиент будет воспринимать это как произвол. Даже если система действует в рамках правил, отсутствие объяснения делает её неприемлемой.

Интересно, что пользователи в этих случаях не обязательно требуют полного понимания внутренней логики модели. Глубокие технические детали – как правило, неинтересны или недоступны неспециалисту. Но крайне важно, чтобы система предоставляла понятные, когнитивно интерпретируемые объяснения – метафоры, аналогии, причинно-следственные связи, визуализации – позволяющие выстроить ментальную модель происходящего.

Потеря доверия часто проявляется не в явных жалобах, а в поведенческой реакции: снижении вовлечённости, отказе от функций, переключении на альтернативы. В долгосрочной перспективе это подрывает саму идею использования ИИ как вспомогательной технологии. Люди перестают ощущать, что ИИ работает с ними – и начинают воспринимать его как автономный, отчуждённый, непонятный элемент в системе.

Проблема ещё более усугубляется тем, что большинство UX-проектов с ИИ по-прежнему сосредоточены на дизайне визуальных слоёв, а не на когнитивной структуре доверия. Интерфейс может быть стилистически современным, но не предоставлять ничего для построения надёжной модели взаимодействия. В результате, система, вложенная в современный UI, может оставаться «чёрным ящиком» в глазах пользователя.

Это приводит нас к необходимости переосмысления роли UX в ИИ: не как оболочки, а как архитектуры объяснения, поддержки, управления и диалога. Именно этот переход и задаёт основное направление Human-Centered AI.

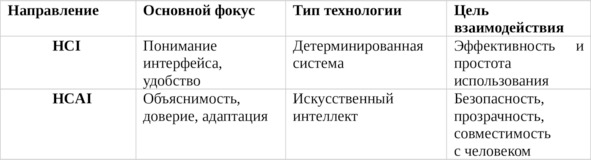

Понятия HCI и HCAI: история и различия

Human-Computer Interaction (HCI) – это область, изучающая проектирование, реализацию и оценку взаимодействия между людьми и компьютерными системами. Термин появился в 1980-х годах на стыке когнитивной психологии, эргономики и инженерии интерфейсов, когда стало очевидно, что эффективность цифровых систем зависит не только от их вычислительных характеристик, но и от того, насколько хорошо они соотносятся с ментальными, сенсорными и моторными возможностями пользователя.

На ранних этапах HCI фокусировалась на юзабилити (usability): понятности, простоте, скорости выполнения задач. Однако с 2000-х годов область стала включать в себя также эмоциональные, поведенческие и контекстные аспекты взаимодействия, превратившись в мультидисциплинарное поле, включающее элементы психологии, лингвистики, дизайна, информатики и социальной теории.

Современное определение HCI можно сформулировать следующим образом:

Human-Computer Interaction – это исследование и практика проектирования технологий, которые адаптированы к возможностям, потребностям и ограничениям человека, с целью обеспечения эффективного, осмысленного и безопасного взаимодействия.

Важным в этом определении является акцент на человеке как активном участнике, а не просто пользователе. Поведение, ожидания, навыки и контекст использования становятся не побочными факторами, а центральными точками проектирования.

Переход к HCAI: от взаимодействия к ответственности

Появление искусственного интеллекта как активного компонента взаимодействия привело к необходимости расширить рамки HCI. Когда система начинает самостоятельно адаптироваться, обучаться на пользовательских данных и предлагать решения, возникает новая степень сложности: взаимодействие приобретает черты социального, неопределённого и потенциально автономного поведения. В этом контексте взаимодействие перестаёт быть только вопросом интерфейса – оно становится вопросом влияния, доверия, прозрачности и справедливости.

Так появляется направление Human-Centered AI (HCAI) – ответ на вызов: как сделать ИИ не просто функциональным, а понятным, полезным и этически допустимым для человека. В отличие от HCI, где взаимодействие строится с детерминированной системой, HCAI работает с системами, поведение которых изменчиво, вероятностно и не всегда поддаётся контролю извне.

В этом смысле, HCAI – это не просто «интерфейс для ИИ», а архитектура взаимодействия, где ИИ встроен в жизненный, социальный и поведенческий контекст человека.

Классическая модель взаимодействия: цикл Нормана

Один из самых влиятельных вкладов в HCI – модель взаимодействия, предложенная Дональдом Норманом (D. Norman, The Design of Everyday Things, 1988). Эта модель объясняет когнитивную структуру взаимодействия между человеком и системой, разбивая её на логические стадии, которые проходят в голове пользователя при выполнении задачи.

Норман выделяет два ключевых цикла:

Гульфа исполнения (Gulf of Execution) – разрыв между намерением пользователя и тем, как это реализуется в системе;

Гульфа оценки (Gulf of Evaluation) – разрыв между тем, что система делает, и тем, как пользователь это воспринимает.

На практике модель описывается как семишаговая когнитивная петля:

1. Формирование цели – что пользователь хочет достичь

2. Формирование намерения – какой план действия нужен

3. Определение последовательности действий – что нажать, выбрать

4. Физическое выполнение действия – ввод, клик, жест

5. Наблюдение за результатами – система выдаёт ответ

6. Интерпретация вывода – что это значит?

7. Оценка состояния системы – всё ли пошло по плану?

Эта модель применима и к простым интерфейсам (например, банкомат), и к сложным ИИ-системам. Однако в случае с ИИ добавляется новая проблема: система может менять поведение в зависимости от данных, адаптироваться, принимать решения автономно. Это означает, что даже при чётком исполнении команды результат может отличаться от ожидаемого, а этапы 5—7 (наблюдение, интерпретация, оценка) становятся ключевыми точками возможного срыва доверия.

Актуальность модели Нормана в эпоху ИИ

В контексте HCAI модель Нормана приобретает новое измерение. Её важность возрастает, потому что именно на стадии оценки поведения ИИ пользователь сталкивается с трудностью: результат может быть корректным математически, но не соответствовать ментальной модели. Это требует от системы не просто интерфейса, а активного участия в объяснении логики своих действий – например, через визуализацию причин, акцентов, уверенности, альтернатив.

Взаимодействие больше не замыкается в схеме «команда—ответ», а превращается в диалог, в котором ИИ должен не только реагировать, но и прозрачно коммуницировать ход своей «мысли».

Как HCAI расширяет HCI: включение машинного обучения, этики и доверия

Системы взаимодействия между человеком и компьютером в рамках классической парадигмы HCI предполагают, что поведение системы определено заранее. Архитектура интерфейса проектируется под жёстко заданные функции, а результат действия пользователя может быть точно предсказан разработчиком. Однако с появлением и активным внедрением систем искусственного интеллекта, в частности машинного обучения (ML), данное допущение более не работает.

ИИ-модели – особенно обучаемые – обладают рядом характеристик, которые принципиально нарушают базовые предпосылки классической HCI. Среди таких характеристик:

Обучение на данных (а не программирование поведения вручную);

Непредсказуемость решений в отдельных случаях (особенно при генеративных или вероятностных выходах);

Адаптация во времени – модель может обновлять внутренние параметры и поведение;

Необъяснимость логики вывода без дополнительной интерпретации.

Это порождает качественно новые задачи, которых не было в традиционной HCI:

Как представить поведение модели так, чтобы оно было понятно человеку?

Как сделать выводы модели интерпретируемыми без глубоких технических знаний?

Как оценить, безопасна ли система для разных типов пользователей?

Как удостовериться, что поведение ИИ не приводит к дискриминации, манипуляции или психологическому дискомфорту?

Эти вопросы формируют обоснование перехода от HCI к Human-Centered AI (HCAI) – более широкому подходу, который включает в повестку не только дизайн интерфейса, но и:

Интеграцию методов машинного обучения в пользовательский контекст. ML-модели требуют новых форм визуализации, настройки и взаимодействия:

1. Пользователь должен понимать, на основе каких данных сделан вывод;

2. Необходимо отображать уровень уверенности модели, а не просто результат;

3. Интерфейс должен предлагать альтернативные варианты, позволяя сравнивать решения.

В результате проектирование HCAI включает в себя XAI-практики (Explainable AI): объяснимость решений, визуальные метафоры, комментарии модели, причинно-следственные графы. Это требует от дизайнеров и исследователей не только навыков UX, но и понимания поведения обучаемых моделей.

Этика и социальная ответственность как часть дизайна

Классическая HCI в меньшей степени касалась нормативных или этических вопросов. Система рассматривалась как инструмент, нейтральный по определению. Однако ИИ, в силу своей способности усиливать предвзятость, воспроизводить структурное неравенство и действовать вне прозрачного алгоритма, требует включения этики как обязательного проектного уровня.

Это означает:

– необходимость оценивать справедливость алгоритма по отношению к разным социальным группам;

– учитывать последствия автоматизированных решений для конкретных категорий пользователей;

– обеспечивать обратную связь и возможность пересмотра или отмены решений ИИ;

– внедрять принципы responsibility-by-design – ответственность за результат не только после внедрения, но и на этапе проектирования.

В рамках HCAI эти аспекты превращаются из «желательных» в структурно необходимых.

Доверие как инженерная и психологическая категория

В HCI доверие к интерфейсу основывалось на стабильности, скорости, понятности. В HCAI доверие к системе включает гораздо более широкий спектр факторов:

Понимает ли пользователь, как система принимает решения?

Может ли он предсказать поведение ИИ в нестандартной ситуации?

Чувствует ли он, что может контролировать результат?

Есть ли у него возможность оспорить автоматическое действие?

Ощущает ли он, что система учитывает его интересы, а не просто оптимизирует метрику?

Таким образом, доверие становится центральной проектной переменной. Его нельзя «добавить» на финальном этапе. Оно должно быть интегрировано в архитектуру поведения системы, а также поддерживаться через объяснения, прозрачность, управление ожиданиями и понятный интерфейс.

HCAI не противопоставляется HCI, а дополняет и расширяет его, адаптируя классические методы к новым вызовам, связанным с:

– вероятностной природой ИИ,

– непредсказуемыми последствиями автоматизации,

– необходимостью верификации и объяснения логики модели,

– учётом социальных, правовых и эмоциональных последствий.

Если HCI – это проектирование взаимодействия с интерфейсом, то HCAI – это проектирование совместной деятельности человека и ИИ, в которой важно не только, что делает машина, но и как это воспринимается, понимается и используется человеком.

Этапы развития пользовательских интерфейсов

Эволюция интерфейсов: от CLI до AI-driven UX

Современные технологии взаимодействия между человеком и цифровыми системами представляют собой результат многолетней эволюции. На каждом этапе – от командной строки до интеллектуальных систем – менялась не только форма интерфейса, но и сама природа взаимодействия, а вместе с ней – ожидания пользователя, когнитивная нагрузка, дизайнерские задачи и принципы проектирования. Понимание этой эволюции необходимо для осознания, почему появление HCAI – не просто технологический тренд, а логическая необходимость следующего поколения взаимодействия.

I. CLI – Command Line Interface (1970—1980-е годы)

Характеристики:

– Взаимодействие через текстовые команды;

– Пользователь должен помнить синтаксис и параметры;

– Минимальная визуальная обратная связь;

– Высокий порог входа, низкий уровень интуитивности.

Восприятие пользователя:

– Интерфейс воспринимался как «язык машины», требующий изучения;

– Пользователь чувствовал себя «гостем» в системе: допуск к вычислению – через знание;

– Отсутствие визуальных ориентиров означало высокую когнитивную нагрузку.

Дизайнерские задачи:

– Были минимальными: дизайн «интерфейса» сводился к логике команд;

– Основной акцент – на документации и логике командной оболочки;

– UX в современном понимании отсутствовал – взаимодействие рассматривалось как программирование.

CLI дал пользователю доступ к мощным функциям, но требовал навыков. Он не адаптировался к человеку – человек адаптировался к машине.

II. GUI – Graphical User Interface (1980—2000)

Характеристики:

– Метапафоры (папки, окна, иконки), визуальное представление команд;

– Взаимодействие через мышь, меню, кнопки;

– Низкий когнитивный порог: система говорит на «языке пользователя».

Восприятие пользователя:

– Резкий рост доступности: компьютеры стали восприниматься как инструмент, а не как терминал;

– Пользователь ориентируется визуально, не запоминая команд;

– Интерфейс стал самодокументируемым: подсказки, визуальные иерархии, affordances.

Дизайнерские задачи:

– Проектирование стало мультимодальным: требовалось учитывать композицию, поведение, метафору;

– Появился UX как дисциплина: usability, тестирование, паттерны взаимодействия;