Но даже если этого не произойдет, может возникнуть ряд негативных эффектов: например, падение конверсии[26] и накопление поведенческой статистики на неправильной странице. Целевая страница при этом может вообще пропасть из индекса (в самом деле, зачем держать в базе несколько копий одной и той же страницы?).

В-четвертых, может возникнуть ситуация, когда поисковая система не сможет разобраться, какой из дублей следует считать основным. В этом случае алгоритм понизит обе страницы (и сайт в целом) в результатах выдачи.

Причины возникновения дублей и методы их обнаружения

Причины возникновения дублей могут быть разными:

1. Дубли штатно или по ошибке может генерировать движок сайта. Например, дублями могут быть страница и ее версия для печати, встречаются дубли главной страницы (site.ru и site.ru/index.php) или одинаковые страницы с разными расширениями (.php и. html).

2. Дубли могут возникнуть из-за невнимательности вебмастера (после изменения адреса страницы она становится доступна и по старому, и по новому URL).

3. Дубли могут генерироваться из-за дизайнерских или контентных особенностей проекта (в интернет-магазинах часто похожие товары отличаются лишь очень кратким описанием или несколькими техническими параметрами).

Для обнаружения дубликатов есть множество эффективных инструментов:

1. Панели для веб-мастеров поисковых систем[27]. С помощью этих веб-сервисов также можно следить за скачиваемыми страницами и находить дубли.

2. Расширенный поиск в поисковых системах. Для Гугла можно использовать site: имя_хоста[28]. В Яндексе можно смотреть индекс по отдельным разделам с помощью url: имя_хоста/категория/*[29] (для этого же можно использовать оператор inurl).

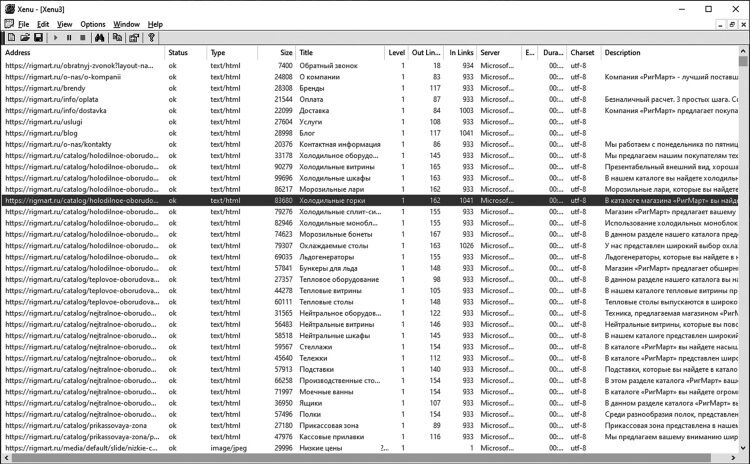

3. Специальные сервисы и программы. Например, можно воспользоваться программой XENU[30], а также некоторыми распространенными веб-сервисами, информацию о которых легко найти в Сети (см. рис. 2 на с. 54).

Устранение дублей может быть сложным и зачастую требует творческого подхода. Однако есть направления, которые однозначно стоит проверить.

Ошибки движка сайта

Разберем типичные ошибки работы движка сайта, которые приводят к появлению дублей:

1. Движок сайта не генерирует 301 редирект при смене адреса страницы (этот редирект либо нельзя поставить вообще, либо нужно ставить в ручном режиме, о чем легко забыть). Данный недостаток легко устранить на программном уровне.

Рис. 2. Результаты сканирования сайта программой XENU: интерфейс безнадежно устарел, но функционал остается полезным при выполнении практических задач

2. Движок отображает один и тот же контент по разным адресам:

a. Разные страницы могут возникать при перестановке частей URL-адреса. Например, одинаковый контент выводится на страницах site.ru/cars/volvo и site.ru/volvo/cars.

b. Отображение страницы происходит при частичном вводе адреса, например по URL site.ru/sumki/cristina-agilera и site.ru/sumki/cristina.

c. Одна и та же страница может отображаться в разных категориях. Особенно это актуально для карточек товаров в интернет-магазине: site.ru/moto/sc-234 и site. ru/moto-s-pricepom/sc-234. Проще всего решить эту проблему, присвоив каждой карточке раз и навсегда свой уникальный адрес.

3. Движок сайта может генерировать сессионные переменные в адресе страниц. Ниже мы разберемся с этим вопросом подробнее.

Сессия – промежуток времени, в течение которого пользователь находился на сайте[31]. Когда пользователь заходит на сайт, последний с помощью cookies[32] браузера его идентифицирует. Это необходимо, чтобы понять, кто этот посетитель, и помочь ему пользоваться сайтом. Например, если при авторизации пользователь поставил галочку «Запомнить меня», то при следующем заходе на сайт он сразу будет залогинен.

Но бывает, что cookies у пользователя отключены. В таком случае возможны три варианта:

– сайт будет работать, как обычно;

– сайт не сможет работать полноценно и выдаст сообщение, что для нормальной работы нужно включить cookies;

– движок сайта постарается компенсировать отсутствие cookies с помощью так называемых сессионных переменных (уникальных идентификаторов, которые будут добавляться к URL тех страниц, на которых побывал пользователь).

Последний подход создает дополнительные проблемы для поисковых систем. Их роботы приходят на сайт, видят новые URL с сессионными переменными и индексируют их. В результате в поисковую базу попадают полные дубликаты уже существующих страниц.

Конечно, поисковые системы отфильтровывают большинство таких страниц, но эта ситуация негативно влияет на индексацию и ранжирование сайта. Если движок сайта генерирует сессионные переменные, необходимо этот механизм отключить.

301 редирект

В основном 301 переадресацию[33] (жарг. «301 редирект») используют при смене URL-страницы, но эта технология пригодится и для борьбы с дублями.

Дело в том, что код статуса 301 означает, что запрашиваемая страница окончательно перемещена в новое местоположение. А поэтому, если настроить 301 редирект с дубля на основной документ, дубль пропадет из поисковой базы.

Необходимо настроить постраничный 301 редирект:

1. C домена без «www» на домен с «www» (или наоборот, в зависимости от того, какой вариант лучше проиндексирован поисковиками, накопленной ссылочной массой и индивидуальных предпочтений).

2. Со страниц без слэша («/») на конце адреса на страницы со слэшем (или наоборот, в зависимости от особенностей сервера и собственных предпочтений). Отметим, что адреса без косой черты на конце предпочтительнее, так как косая черта ассоциируется с каталогом, а не с конечной страницей на сайте.

3. Со страниц, адрес которых оканчивается на «.htm», на страницы вида «.html».

4. С версии сайта «http» на версию «https».

5. С дублей главной страницы сайта (вида «index.php», «index.html», «default.html») на главную. Если такой редирект невозможен из-за особенностей системы, необходимо запретить дубли в файле robots.txt, а также проверить актуальность проблемы для других разделов сайта.

6. После настройки ЧПУ (о чем мы поговорим позже) страницы сайта могут быть доступны и по старым, техническим адресам. Если это так, необходимо настроить 301 редирект на страницы с ЧПУ.

Атрибут rel=«canonical»

Часто на сайте присутствуют группы страниц с частичным дублированием контента. Например, это могут быть карточки товаров, отличающиеся только отдельными параметрами (например, один и тот же стол с разной длиной столешницы), или страницы блога с одной и той же статьей, но разными URL-адресами.

В этом случае необходимо оптимизировать индексацию страниц сайта с использованием вспомогательного атрибута rel=«canonical»[34], с помощью которого можно указать предпочитаемый (канонический) адрес, который будет участвовать в поиске.

Правильно настроенный атрибут rel=«canonical» помогает существенно упростить настройку индексации сайта и устранить дубликаты страниц для корректного учета всех поведенческих и ссылочных метрик документов. Другими словами, поисковые системы «склеят» страницы с частично дублированным контентом вместе со всеми метриками. Особенно это актуально при проведении рекламных кампаний, например, с использованием UTM-меток[35].

Общий план действий:

1. Проанализировать сайт и определить страницы с частично дублированным контентом (страницы с параметрами в URL, дубли одной страницы в разных категориях, похожие товары и прочее).

2. Из группы похожих страниц выбрать каноническую и добавить в код неканонических страниц атрибут rel=«canonical». Желательно, чтобы атрибут ставился программным способом – это существенно облегчит администрирование сайта.

Остается добавить, что из-за несовершенства алгоритмов rel=«canonical» не всегда обрабатывается корректно. Это приводит к отсутствию «склейки» поведенческих и ссылочных факторов ранжирования. Поэтому надежнее использовать 301 редирект везде, где это только возможно.

301 редирект или rel=«canonical»?

Давайте определим, какой способ и когда лучше использовать.

301 редирект лучше:

1. Просто по умолчанию. Это более предпочтительный метод вследствие того, что rel=«canonical» не всегда обрабатывается корректно.

2. Если у страницы навсегда изменился адрес.

3. Если сайт переехал на новый домен.

4. Если администратор сайта удалил какую-то страницу, но вместо 404 ошибки хочет показать пользователям другую, схожую с удаленной, информацию (например, другой товар взамен удаленного).

rel=«canonical» лучше:

1. Когда 301 редирект не может быть реализован или его внедрение потребует слишком больших затрат.

2. Когда имеет смысл показывать частично дублированный контент пользователям. Например, несколько страниц стола с разной длиной столешницы можно показывать в расчете на более высокую конверсию, особенно если на эти страницы ведут специальные объявления из систем контекстной рекламы.

3. Когда нужно показывать страницы с почти одинаковым содержимым (например, сортировки каталога, отслеживания партнерских ссылок).

4. Для кросс-доменов, когда оба сайта похожи, но похожий контент нужно оставить на каждом из доменов. Эта ситуация может быть опасна из-за аффилирования, о чем мы поговорим в разделе, посвященном санкциям поисковых систем.

Ошибки при использовании редиректов

Закрывая тему редиректов, хочется рассказать об ошибках, которых стоит избегать:

1. Необходимо делать правильный выбор между 301 редиректом и rel=«canonical».

2. Нужно избегать любых многошаговых редиректов. Одношаговый редирект быстрее работает и сохраняет максимум ссылочного веса. Кроме того, если на сайте будут замечены многошаговые редиректы, поисковая система может решить, что ваша страница – дорвей. А это повлечет серьезнейшие санкции для сайта.

✍ На заметку

Дорвей[36] (от англ. doorway – входная дверь, портал) или входная страница, – один из видов поискового спама. Это веб-страница, специально оптимизированная под один или несколько поисковых запросов с целью ее проникновения на высокие места в результатах поиска и дальнейшего перенаправления посетителей на другой сайт или страницу.

Дорвей не представляет никакой ценности, и пользователь даже не успевает его рассмотреть – его сразу перенаправляют на другой сайт. Контент дорвея, как правило, лишен смысла и генерируется автоматически по специальным алгоритмам (писать руками слишком затратно). Часто это просто набор фраз, в который внедрены ключевые слова.

Дорвеи – это веб-мусор, поэтому все поисковые машины беспощадно с ними борются.

3. Нужно применять правильные виды редиректов[37], чтобы не запутать поискового робота.

4. При внедрении редиректа необходимо позаботиться о том, чтобы на сайте не осталось ссылок со старым URL-адресом (с которого и выполняется перенаправление).

5. Редирект желательно ставить на максимально релевантную страницу. Например, на похожую карточку товара или ветку каталога, к которому принадлежала страница. Если это невозможно, лучше выдавать 404 ошибку, о которой мы поговорим чуть позже.

6. Редирект должен вести на действующую страницу (с кодом ответа 200 ОК). Иначе нужно вернуть 404 ошибку.

Robots.txt

Robots.txt – это специальный служебный файл, расположенный в корневом каталоге сайта[38], который является незаменимым помощником в борьбе с дублями и нецелевыми страницами, попавшими в индекс. Следует обязательно создать этот файл в соответствии с рекомендациями поисковых систем[39], а затем указать в нем страницы и данные, которые поисковым роботам не следует индексировать.

Перечислим типичные разделы и страницы с дублированным контентом, индексацию которых стоит запретить в файле robots.txt:

– страницы фильтраций и сортировок с дублированным контентом;

– страницы с UTM-метками;

– результаты поиска;

– тестовые страницы, поддомены и серверы;

– RSS-фиды.

В файл также следует добавить разделы с малоинформативным и служебным контентом:

– служебные страницы и файлы, логи сайта, страницы с внутренней статистикой, вход в административную панель, кэш страниц, подгружаемые модули и другие технические страницы;

– страницы авторизации, смены и напоминания пароля;

– «висячие узлы», то есть страницы, с которых нет ссылок на другие страницы сайта (например, версия страницы для печати);

– страницы совершения действия (добавления в корзину, оформления заказа и прочее);

– страницы с динамическими параметрами[40];

– неинформативные или пустые doc- и pdf-файлы (такие файлы лучше не просто закрывать от индексации, а удалять с сайта). При этом надо помнить, что, если такие файлы уникальны и несут полезную информацию, их не закрывают от индексации.

Приведенные списки не являются исчерпывающими. Каждый движок имеет свои особенности, поэтому желательно делать регулярную проверку, выявлять дубли и «мусорные» страницы и запрещать их к индексации.

Надо отметить, что запрещение индексации разделов через файл robots.txt без скрытия ссылок на них может приводить к тому, что эти разделы все же попадут в индекс со всеми вытекающими последствиями.

Про robots.txt профессионалы даже шутят, что он как презерватив: вроде бы защищает, но гарантий никаких.

Поэтому желательно просто убирать ссылки на нежелательные разделы из клиентской части сайта: так вы надежно скроете их и от поисковых роботов, и от пользователей.

В файле robots.txt следует указать ссылку на карту сайта с помощью директивы Sitemap[41].

Остается добавить, что для анализа корректности файла robots.txt нужно воспользоваться валидаторами поисковых систем[42].

11. Оптимизация заголовков

При оптимизации заголовков встречается много ошибок. Давайте разберем типичные недостатки и поймем, как их избежать.

Заголовок hl

Согласно многим исследованиям, заголовок h1[43] зачастую работает как «второй тайтл», поэтому к нему нужно относиться максимально внимательно:

1. Заголовок h1 единожды должен присутствовать на каждой странице сайта. Повторное использование тегов заголовка h1 на странице недопустимо.

2. Заголовок должен «перекликаться» с тегом

, допускается частичное или даже полное дублирование.</p><p>3. Заголовок должен однозначно визуально идентифицироваться на странице, чтобы пользователь сразу понимал содержание текущего раздела. Добиться выделения заголовка можно с помощью размера букв, шрифта, цвета и других приемов.</p><p>4. В теле заголовка желательно использовать ключевые слова, но переоптимизация (чрезмерное употребление) недопустима.</p><br/><div style="text-align: center"><img src="/img/58535581/i_004.jpg"></img></div><p><strong>Рис. 3. Сайт htmlbook.ru – полезный справочник для любого вебспециалиста</strong></p><br/><p><strong><em>Теги h2-h6</em></strong></p><p>Перечислим основные рекомендации, которые помогут правильно применять второстепенные заголовки:</p><p>1. Заголовки пришли в Интернет со страниц газетных полос и по возможности должны следовать газетной традиции визуального оформления: h1 должен быть самым крупным и заметным, h2 – меньше, h3 – еще мельче. Так пользователь сможет легче понять иерархию текста на странице.</p><p>2. Оптимально использовать только теги h1-h3. Теги h4-h6 почти бесполезны для поискового продвижения, а их использование свидетельствует о проблемах с текстом на странице: он слишком подробно поделен на отдельные части и его необходимо сделать более однородным. Для больших информационных порталов (словарей, справочников и т. п.) допускается также использование h4. Теги h5-h6 лучше не использовать никогда.</p><p>3. Ключевые слова в заголовках h2 и h3 могут быть слабым сигналом релевантности, поэтому этим надо пользоваться. Нужно размещать ключевые слова в этих элементах, но не во всех, так как это может быть признаком текстовой переоптимизации, за которую поисковые системы наложат на страницу санкции.</p><br/><p><strong><em>Типичные ошибки</em></strong></p><p>Перечислим типичные ошибки, которых следует избегать:</p><p>1. Тегами заголовков можно выделять только заголовки в контентной (текстовой) части страницы. Другие варианты их применения в верстке недопустимы.</p><p>Для оформления контента вне основной области страницы (шапка, левая/правая колонка, подвал сайта) можно создать и использовать специальные css-классы.</p><p>2. По возможности нужно стараться делать код заголовков более «чистым», без дополнительных тегов и классов. Идеально: <й1>Текст заголовка< /h1>. Это не влияет на продвижение сайта, но поможет придерживаться единого стиля заголовков на всем сайте.</p><p>3. Не следует перебарщивать с количеством подзаголовков h2 и h3 на странице. Их количество должно быть адекватно количеству текста (в среднем – один подзаголовок на 800-1500 символов).</p><p>Помимо технических задач, связанных с продвижением, заголовки играют большую роль в удержании пользователей и повышении конверсии. Эти аспекты мы подробно разберем в соответствующих разделах.</p></section><section><h3><p>12. Настройка адресации</p></h3><p>Правильная адресация помогает пользователям ориентироваться на сайте и способствует повышению позиций сайта в поисковой выдаче. Ее необходимо оптимизировать на самом раннем этапе работ, иначе можно потерять часть уже достигнутых при продвижении результатов.</p><br/><p><strong><em>ЧПУ</em></strong></p><p>Как известно, к сайту можно обратиться по его URL[44]. URL (англ. Uniform Resource Locator, «урл») – это единый указатель (адрес) ресурса. URL служит стандартизированным способом записи адреса ресурса в Интернете.</p><p>Все без исключения страницы сайта должны иметь человеко-понятный урл (ЧПУ). Так на профессиональном жаргоне называют веб-адрес, содержащий читаемые слова вместо служебных параметров, более удобных для компьютера, чем для людей (например, числовых идентификаторов страницы).</p><p>Такой адрес состоит из букв латинского (английского) алфавита, цифр и знака «-» (дефиса), который используется для отделения слов друг от друга вместо пробела. ЧПУ отражает виртуальную иерархическую структуру сайта (физически такая структура папок и файлов на сервере может и не существовать). Пример такого адреса: http://site.ru/katalog/igrushki/kubik-rubika</p><p>В Гугле такие адреса называют простыми[45]. И действительно, чтобы добиться такой адресации, структуру сайта нужно делать предельно простой, логичной и понятной. Это поможет пользователям просматривать сайт, а роботам – правильно его индексировать.</p><p>ЧПУ должен дублировать структуру сайта. Вот примеры того, как он должен выглядеть для разных разделов:</p><p>– [главная страница]</p><p>– [главная страница] + [раздел]</p><p>– [главная страница] + [раздел] + [подраздел]</p><p>– [главная страница] + [раздел] + [подраздел] + [страница]</p><p>Приведем простой алгоритм образования URL-адреса из заголовка страницы. Это оптимальный способ автоматического формирования ЧПУ, но важно соблюдать последовательность действий:</p><p>1. Преобразовать строку заголовка страницы в нижний регистр.</p><p>2. Заменить символы кириллицы согласно таблице ниже.</p><br/><div style="text-align: center"><img src="/img/58535581/i_005.png"></img></div><br/><p>1. Все символы, кроме допустимых (знака тире, букв и цифр), заменить на «-» (включая пробел). Регулярное выражение для замены [^-a-zQ-9].</p><p>2. Заменить несколько идущих подряд «-» на один «-».</p><p>3. Проверить и удалить, в случае необходимости, символ «-» на первой и последней позиции в строке.</p><p>4. К полученному результату слева присоединить косую черту и ЧПУ раздела, находящегося на один уровень выше текущего. Понятно, что самым верхним уровнем будет домен сайта.</p><p>Для проверки качества ЧПУ можно провести простой тест: дать контрольной группе пользователей только URL-адрес нескольких разделов сайта и попросить описать, чему посвящены эти страницы. Если у них возникнут проблемы – стоит внести коррективы.</p><br/><p><strong><em>Важные замечания</em></strong></p><p><strong>Спам. </strong>ЧПУ не должен быть заспамлен, то есть в нем не должно быть слишком много ключевых слов (тем более они не должны повторяться!). Если ЧПУ формируется из заголовка, то сначала необходимо оптимизировать заголовки согласно ранее данным рекомендациям.</p><p><strong>Длина. </strong>URL-адрес должен быть коротким. Хорошим тоном считается удерживать длину адреса в пределах 150–200 символов. Это удобно для пользователей и радует поисковых роботов.</p><p><strong>Ключевые слова. </strong>В адресе обязательно нужно использовать ключевые слова. Это не только поможет пользователям лучше понимать структуру адресов сайта, но и может улучшить кликабельность на странице поисковой выдачи, так как ключевые слова там выделяются жирным шрифтом.</p><p><strong>Подразделы вместо поддоменов. </strong>Без крайней необходимости не стоит выносить контент за пределы основного домена сайта (на поддомены).</p><p>В общем случае домен и его поддомен поисковыми системами воспринимаются как два разных сайта. Соответственно, если весь контент агрегируется на основном домене, можно получить синергетический эффект при продвижении за счет роста размера сайта, ссылочной массы и поведенческой статистики. Если вынести часть контента на поддомены, в общем случае вместо одного «сильного» сайта получится несколько «слабых», которые даже в совокупности будут генерировать гораздо меньше трафика.</p><p><strong>Нижний регистр. </strong>Все URL должны быть в нижнем регистре. Если на сайте использовался верхний регистр, нужно настроить 301 редирект на страницы в нижнем регистре.</p></section><section><h3><p>13. Файл Sitemap.xml</p></h3><p>Sitemap.xml – это служебный файл[46] карты сайта в формате XML[47], который позволяет сообщить поисковым системам информацию о том, как организованы данные на продвигаемом вебресурсе. В нем содержатся ссылки на все разделы и страницы, которые должны быть проиндексированы поисковыми роботами.</p><p>Как правило, sitemap.xml на больших или часто изменяющихся сайтах генерируется на лету (этот процесс легко автоматизировать). Реальный адрес файла вовсе не обязан быть site. ru/sitemap.xml: он может быть абсолютно любым, например, site.com/anything (хотя лучше, конечно, чтобы у карты сайта был осмысленный адрес).</p><p>Поисковые роботы регулярно скачивают файл карты сайта, сравнивают его с имеющейся у них версией и, если файлы отличаются (например, в скачанной версии добавились новые ссылки), индексируют изменения на сайте.</p><p>Помимо новых ссылок, файлы Sitemap помогают передать поисковику метаданные о страницах сайта. Например, можно указать дату последнего изменения, периодичность обновления контента и важность страницы на сайте по сравнению с другими разделами.</p><p>Существуют отдельные виды файлов для разных типов контента, включая видео[48] и изображения[49]. Для абсолютного большинства веб-проектов генерировать их нет смысла, но, если для продвигаемого проекта это актуально, рекомендуется разработать в движке функционал, позволяющий автоматически генерировать и обновлять соответствующие документы.</p><br/><p><strong><em>Необходимость файла sitemap.xml</em></strong></p><p>Некоторые исследователи придерживаются мнения, что файл sitemap.xml не нужен для большинства сайтов. Якобы структуру веб-ресурса нужно делать настолько простой и удобной, чтобы поисковые роботы смогли без проблем добраться до любой страницы сайта и проиндексировать ее. Такая структура гораздо лучше подходит не только для поисковиков, но и для пользователей. Им становится проще пользоваться сайтом, что улучшает поведенческие факторы ранжирования (например, количество и глубину переходов, время на сайте).</p><p>Исключение составляют масштабные информационные и e-commerce проекты, где просто-напросто слишком много страниц, и сделать их все относительно легкодоступными не всегда представляется возможным.</p><p>С тем, что структуру ресурса нужно делать удобной, никто не спорит (подробнее мы поговорим об этом в главе про структурную оптимизацию сайта). И действительно, если страницы сайта корректно и полно связаны друг с другом, поисковый робот сможет рано или поздно обнаружить все материалы. Однако это не отменяет необходимости настраивать sitemap.xml для всех сайтов.</p><p>Sitemap.xml является слабым сигналом качества сайта и повышает уровень траста сайта. Даже для небольших проектов он способен помочь поисковым роботам более точно и оперативно индексировать все изменения на сайте.</p><p>Кроме того, файл карты сайта однозначно нужен, если:</p></div></div><div class="PaginationBlock_paginationBlock__ESqX_ PaginationBlock_paginationBlock_bottom__LljhQ"><div class="PaginationBlock_paginationBlock__pages__KDW6d"><div><div class="Pagination_pagination__thWr5 Pagination_pagination_noMargin__QOW6m"><a class="Previous_prev__nRln6" href="/online/529375/2"><</a><a class="Pagination_pagination__link__innVr" href="/online/529375/1">1</a><a class="Pagination_pagination__link__innVr" href="/online/529375/2">2</a><a class="Pagination_active__FIUxq" href="/online/529375/3">3</a><a class="Pagination_pagination__link__innVr" href="/online/529375/4">4</a><a class="Pagination_pagination__link__innVr" href="/online/529375/5">5</a><a class="Pagination_pagination__link__innVr" href="/online/529375/6">6</a><a class="Next_next__5tJXc" href="/online/529375/4">></a></div></div></div><div><div><div class="PaginationBlock_pagesInput__controls__OQi14"><span class="PaginationBlock_pagesInput__txt__wP7Er">На страницу:</span><div class="PaginationBlock_pagesInput__input__5EMpR"><input data-page-go-input="true" class="PaginationBlock_formInput__field__BCaW4" name="page-number" type="number" min="1" max="6" placeholder="1" value="1"/></div><div class="PaginationBlock_pagesInput__btn__iKpTu"><a data-page-go-button="true" class="PaginationBlock_paginationBlock__btn__7ClWN" href="/online/529375/1">Перейти</a></div><div class="PaginationBlock_pagesInput__count__CTnof"><span data-current-page="{{ currentPage }}">3</span> <!-- -->из<!-- --> <span data-total-pages="{{ totalPages }}">6</span></div></div></div></div></div></div><ul class="Footer_footer__kObrD"><li class="Footer_footer__item__hf0GU"><a target="_blank" class="Footer_footer__link__HDQvh" href="https://www.litres.ru/?lfrom=1258056579">Litres.ru</a></li><li class="Footer_footer__item__hf0GU"><a target="_blank" class="Footer_footer__link__HDQvh" href="/redirect_to_self_pub">Стать автором</a></li><li class="Footer_footer__item__hf0GU"><a target="_blank" class="Footer_footer__link__HDQvh" href="/redirect_to_my_book">MyBook.ru</a></li></ul><div class="Layout_mainContainer__bottomBanner__qtLRD"><div class="undefined FooterBanner_rtbBanner_desktop__MTpQ6"><div id="yandex_rtb_R-A-745629-5"></div></div><div class="undefined FooterBanner_rtbBanner_mobile__4OC92"><div id="yandex_rtb_R-A-745629-4"></div></div></div></div><div class="Layout_mobileOverlay__PjzPa"></div></main><div class="StickyBanner_sticky_banner__NC2R_ " data-sticky-banner="true"><div class="StickyBanner_sticky_banner_btn__RQPM3" data-sticky-banner-btn="true"></div><div class="StickyBanner_sticky_banner_wrap__tQTE_"><div id="yandex_rtb_R-A-745629-6"></div></div></div></div><div id="adCounters"><script async="" type="text/javascript" src="/static/ya-counter.js"></script><noscript><div><img src="https://mc.yandex.ru/watch/32856290" style="position:absolute;left:-9999px"/></div></noscript></div></div><script id="__NEXT_DATA__" type="application/json">{"props":{"pageProps":{"book":{"id":529375,"book_id":411822,"alias":"529375","views_count":302,"comments_count":0,"rating":5,"voted_users":26,"type":"book","genres":[{"id":5048,"parent_id":5003,"title":"маркетинг, PR, реклама","alias":"marketing_pr_reklama"},{"id":5337,"parent_id":5048,"title":"интернет-маркетинг","alias":"internet_marketing"},{"id":54725,"parent_id":0,"title":"поисковые системы","alias":"poiskovye-sistemy"},{"id":66495,"parent_id":0,"title":"веб-программирование","alias":"veb-programmirovanie"},{"id":72275,"parent_id":0,"title":"эффективное продвижение","alias":"effektivnoe-prodvizhenie"},{"id":92855,"parent_id":0,"title":"увеличение прибыли","alias":"uvelichenie-pribyli"},{"id":115647,"parent_id":0,"title":"продвижение сайта","alias":"prodvizhenie-saita"}],"author":{"id":154340,"alias":"sergey-anisimov-24757186","views_count":398,"comments_count":0,"books_count":1,"status":"active","first_name":"Сергей","middle_name":"","last_name":"Анисимов"},"tags":[{"id":781,"title":"эффективное продвижение","alias":"effektivnoe-prodvizhenie","book_count":381},{"id":1094,"title":"веб-программирование","alias":"veb-programmirovanie","book_count":189},{"id":1526,"title":"продвижение сайта","alias":"prodvizhenie-saita","book_count":81},{"id":4687,"title":"поисковые системы","alias":"poiskovye-sistemy","book_count":25},{"id":5283,"title":"увеличение прибыли","alias":"uvelichenie-pribyli","book_count":176}],"series":[{"id":3788,"title":"1000 бестселлеров","title_translit":"1000-bestsellerov","number":0,"other_series_books":[{"external_id":73223098,"title":"Океан ошибок, или сам себе шкипер","book_id":87643311,"alias":"87643311","author_alias":"svetlana-gavrilova","author_id":128194},{"external_id":7379495,"title":"Для ума. Тренинг от настоящего миллионера","book_id":298890,"alias":"298890","author_alias":"vladimir-nikonov-4059575","author_id":100889},{"external_id":17186498,"title":"Учебный центр на «Отлично». Руководство по развитию учебного центра от идеи до масштабирования","book_id":298939,"alias":"298939","author_alias":"aleksey-beba","author_id":97227},{"external_id":22218427,"title":"50 секретов успеха в МЛМ. Рассказывай истории и богатей","book_id":220587,"alias":"220587","author_alias":"valentina-lagutkina","author_id":75729},{"external_id":22500438,"title":"50 секретов воспитания детей, или Как воспитать сына, который строит дом","book_id":249220,"alias":"249220","author_alias":"elena-uzhakova","author_id":84029}]}],"book":{"id":411822,"author_id":126590,"external_id":58535581,"external_uid":"1260ef68-f68d-11ea-ae9a-0cc47a5f137d","title":"Поисковое продвижение сайтов","alias":"poiskovoe-prodvizhenie-saytov-58535581","description":"В интернет-маркетинге существуют четкие критерии успешности веб-проекта: рост посещаемости, увеличение конверсии и прибыли. Задача книги – помочь читателю быстро и без лишних усилий достигнуть этих целевых показателей.\nВ тексте изложены принципы работы поисковых систем, результаты исследований экспертов и авторские наработки по продвижению сайтов. При этом книга задумывалась именно как практическое руководство по поисковой оптимизации, поэтому материал представлен в максимально простой форме, а все рекомендации приведены по принципу «бери и делай».\nКнига адресована широкому кругу читателей: собственникам и топ-менеджерам бизнеса, начинающим и опытным специалистам по продвижению, интернет-маркетологам, дизайнерам, веб-программистам, студентам, а также всем, чьи интересы и деятельность непосредственно связаны с Интернетом.\n\nВ формате PDF A4 сохранен издательский макет.","type":"book","lang":"ru","src_lang":"ru","year":2020,"publish_year":null,"publish_city":null,"pub_date":"2020-09-22T00:00:00","publisher":"1000 бестселлеров","release_date":null,"photo":null,"allow_full_free":0,"has_trial":4,"price":null,"hot":0,"isbn":"978-5-001-44212-7","audio_url":null,"genres":[{"id":5048,"parent_id":5003,"title":"маркетинг, PR, реклама","alias":"marketing_pr_reklama"},{"id":5337,"parent_id":5048,"title":"интернет-маркетинг","alias":"internet_marketing"},{"id":54725,"parent_id":0,"title":"поисковые системы","alias":"poiskovye-sistemy"},{"id":66495,"parent_id":0,"title":"веб-программирование","alias":"veb-programmirovanie"},{"id":72275,"parent_id":0,"title":"эффективное продвижение","alias":"effektivnoe-prodvizhenie"},{"id":92855,"parent_id":0,"title":"увеличение прибыли","alias":"uvelichenie-pribyli"},{"id":115647,"parent_id":0,"title":"продвижение сайта","alias":"prodvizhenie-saita"}],"webtoon":false},"files":[{"type":"fb2.zip","size":1330719,"external_file_id":58535581},{"type":"txt","size":529259,"external_file_id":58535581},{"type":"txt.zip","size":183001,"external_file_id":58535581},{"type":"rtf.zip","size":1451315,"external_file_id":58535581},{"type":"a4.pdf","size":6408440,"external_file_id":58535581},{"type":"a6.pdf","size":2274181,"external_file_id":58535581},{"type":"mobi.prc","size":2161182,"external_file_id":58535581},{"type":"epub","size":2220822,"external_file_id":58535581},{"type":"ios.epub","size":1340617,"external_file_id":58535581},{"type":"fb3","size":1322375,"external_file_id":58535581}],"created_at":"2020-09-21T09:30:24","reader":null,"translator":null,"draft":false,"read_online":true,"src_lang":null,"litres_rating":4.4,"livelib_rating":4.8,"hide_litres_data":false,"other_author_books":[],"relative_book":null,"chain_book":[],"external_reviews":[],"livelib_widget_data":null,"retelling_text":null,"external_comments":[],"retaling":false,"similar_authors_count":0,"quotes_count":0,"related_posts":null},"read":{"page":3,"pages":6,"type":"fb2","content":"\u003cp\u003eНо даже если этого не произойдет, может возникнуть ряд негативных эффектов: например, падение конверсии[26] и накопление поведенческой статистики на неправильной странице. Целевая страница при этом может вообще пропасть из индекса (в самом деле, зачем держать в базе несколько копий одной и той же страницы?).\u003c/p\u003e\u003cp\u003eВ-четвертых, может возникнуть ситуация, когда поисковая система не сможет разобраться, какой из дублей следует считать основным. В этом случае алгоритм понизит обе страницы (и сайт в целом) в результатах выдачи.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eПричины возникновения дублей и методы их обнаружения\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eПричины возникновения дублей могут быть разными:\u003c/p\u003e\u003cp\u003e1. Дубли штатно или по ошибке может генерировать движок сайта. Например, дублями могут быть страница и ее версия для печати, встречаются дубли главной страницы (site.ru и site.ru/index.php) или одинаковые страницы с разными расширениями (.php и. html).\u003c/p\u003e\u003cp\u003e2. Дубли могут возникнуть из-за невнимательности вебмастера (после изменения адреса страницы она становится доступна и по старому, и по новому URL).\u003c/p\u003e\u003cp\u003e3. Дубли могут генерироваться из-за дизайнерских или контентных особенностей проекта (в интернет-магазинах часто похожие товары отличаются лишь очень кратким описанием или несколькими техническими параметрами).\u003c/p\u003e\u003cp\u003eДля обнаружения дубликатов есть множество эффективных инструментов:\u003c/p\u003e\u003cp\u003e1. Панели для веб-мастеров поисковых систем[27]. С помощью этих веб-сервисов также можно следить за скачиваемыми страницами и находить дубли.\u003c/p\u003e\u003cp\u003e2. Расширенный поиск в поисковых системах. Для Гугла можно использовать site: имя_хоста[28]. В Яндексе можно смотреть индекс по отдельным разделам с помощью url: имя_хоста/категория/*[29] (для этого же можно использовать оператор inurl).\u003c/p\u003e\u003cp\u003e3. Специальные сервисы и программы. Например, можно воспользоваться программой XENU[30], а также некоторыми распространенными веб-сервисами, информацию о которых легко найти в Сети (см. рис. 2 на с. 54).\u003c/p\u003e\u003cp\u003eУстранение дублей может быть сложным и зачастую требует творческого подхода. Однако есть направления, которые однозначно стоит проверить.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eОшибки движка сайта\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eРазберем типичные ошибки работы движка сайта, которые приводят к появлению дублей:\u003c/p\u003e\u003cp\u003e1. Движок сайта не генерирует 301 редирект при смене адреса страницы (этот редирект либо нельзя поставить вообще, либо нужно ставить в ручном режиме, о чем легко забыть). Данный недостаток легко устранить на программном уровне.\u003c/p\u003e\u003cbr/\u003e\u003cdiv style=\"text-align: center\"\u003e\u003cimg src=\"/img/58535581/i_003.jpg\"\u003e\u003c/img\u003e\u003c/div\u003e\u003cp\u003e\u003cstrong\u003eРис. 2. Результаты сканирования сайта программой XENU: интерфейс безнадежно устарел, но функционал остается полезным при выполнении практических задач\u003c/strong\u003e\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e2. Движок отображает один и тот же контент по разным адресам:\u003c/p\u003e\u003cp\u003ea. Разные страницы могут возникать при перестановке частей URL-адреса. Например, одинаковый контент выводится на страницах site.ru/cars/volvo и site.ru/volvo/cars.\u003c/p\u003e\u003cp\u003eb. Отображение страницы происходит при частичном вводе адреса, например по URL site.ru/sumki/cristina-agilera и site.ru/sumki/cristina.\u003c/p\u003e\u003cp\u003ec. Одна и та же страница может отображаться в разных категориях. Особенно это актуально для карточек товаров в интернет-магазине: site.ru/moto/sc-234 и site. ru/moto-s-pricepom/sc-234. Проще всего решить эту проблему, присвоив каждой карточке раз и навсегда свой уникальный адрес.\u003c/p\u003e\u003cp\u003e3. Движок сайта может генерировать сессионные переменные в адресе страниц. Ниже мы разберемся с этим вопросом подробнее.\u003c/p\u003e\u003cp\u003eСессия – промежуток времени, в течение которого пользователь находился на сайте[31]. Когда пользователь заходит на сайт, последний с помощью cookies[32] браузера его идентифицирует. Это необходимо, чтобы понять, кто этот посетитель, и помочь ему пользоваться сайтом. Например, если при авторизации пользователь поставил галочку «Запомнить меня», то при следующем заходе на сайт он сразу будет залогинен.\u003c/p\u003e\u003cp\u003eНо бывает, что cookies у пользователя отключены. В таком случае возможны три варианта:\u003c/p\u003e\u003cp\u003e– сайт будет работать, как обычно;\u003c/p\u003e\u003cp\u003e– сайт не сможет работать полноценно и выдаст сообщение, что для нормальной работы нужно включить cookies;\u003c/p\u003e\u003cp\u003e– движок сайта постарается компенсировать отсутствие cookies с помощью так называемых сессионных переменных (уникальных идентификаторов, которые будут добавляться к URL тех страниц, на которых побывал пользователь).\u003c/p\u003e\u003cp\u003eПоследний подход создает дополнительные проблемы для поисковых систем. Их роботы приходят на сайт, видят новые URL с сессионными переменными и индексируют их. В результате в поисковую базу попадают полные дубликаты уже существующих страниц.\u003c/p\u003e\u003cp\u003eКонечно, поисковые системы отфильтровывают большинство таких страниц, но эта ситуация негативно влияет на индексацию и ранжирование сайта. Если движок сайта генерирует сессионные переменные, необходимо этот механизм отключить.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003e301 редирект\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eВ основном 301 переадресацию[33] (жарг. «301 редирект») используют при смене URL-страницы, но эта технология пригодится и для борьбы с дублями.\u003c/p\u003e\u003cp\u003eДело в том, что код статуса 301 означает, что запрашиваемая страница окончательно перемещена в новое местоположение. А поэтому, если настроить 301 редирект с дубля на основной документ, дубль пропадет из поисковой базы.\u003c/p\u003e\u003cp\u003eНеобходимо настроить постраничный 301 редирект:\u003c/p\u003e\u003cp\u003e1. C домена без «www» на домен с «www» (или наоборот, в зависимости от того, какой вариант лучше проиндексирован поисковиками, накопленной ссылочной массой и индивидуальных предпочтений).\u003c/p\u003e\u003cp\u003e2. Со страниц без слэша («/») на конце адреса на страницы со слэшем (или наоборот, в зависимости от особенностей сервера и собственных предпочтений). Отметим, что адреса без косой черты на конце предпочтительнее, так как косая черта ассоциируется с каталогом, а не с конечной страницей на сайте.\u003c/p\u003e\u003cp\u003e3. Со страниц, адрес которых оканчивается на «.htm», на страницы вида «.html».\u003c/p\u003e\u003cp\u003e4. С версии сайта «http» на версию «https».\u003c/p\u003e\u003cp\u003e5. С дублей главной страницы сайта (вида «index.php», «index.html», «default.html») на главную. Если такой редирект невозможен из-за особенностей системы, необходимо запретить дубли в файле robots.txt, а также проверить актуальность проблемы для других разделов сайта.\u003c/p\u003e\u003cp\u003e6. После настройки ЧПУ (о чем мы поговорим позже) страницы сайта могут быть доступны и по старым, техническим адресам. Если это так, необходимо настроить 301 редирект на страницы с ЧПУ.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eАтрибут rel=«canonical»\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eЧасто на сайте присутствуют группы страниц с частичным дублированием контента. Например, это могут быть карточки товаров, отличающиеся только отдельными параметрами (например, один и тот же стол с разной длиной столешницы), или страницы блога с одной и той же статьей, но разными URL-адресами.\u003c/p\u003e\u003cp\u003eВ этом случае необходимо оптимизировать индексацию страниц сайта с использованием вспомогательного атрибута rel=«canonical»[34], с помощью которого можно указать предпочитаемый (канонический) адрес, который будет участвовать в поиске.\u003c/p\u003e\u003cp\u003eПравильно настроенный атрибут rel=«canonical» помогает существенно упростить настройку индексации сайта и устранить дубликаты страниц для корректного учета всех поведенческих и ссылочных метрик документов. Другими словами, поисковые системы «склеят» страницы с частично дублированным контентом вместе со всеми метриками. Особенно это актуально при проведении рекламных кампаний, например, с использованием UTM-меток[35].\u003c/p\u003e\u003cp\u003eОбщий план действий:\u003c/p\u003e\u003cp\u003e1. Проанализировать сайт и определить страницы с частично дублированным контентом (страницы с параметрами в URL, дубли одной страницы в разных категориях, похожие товары и прочее).\u003c/p\u003e\u003cp\u003e2. Из группы похожих страниц выбрать каноническую и добавить в код неканонических страниц атрибут rel=«canonical». Желательно, чтобы атрибут ставился программным способом – это существенно облегчит администрирование сайта.\u003c/p\u003e\u003cp\u003eОстается добавить, что из-за несовершенства алгоритмов rel=«canonical» не всегда обрабатывается корректно. Это приводит к отсутствию «склейки» поведенческих и ссылочных факторов ранжирования. Поэтому надежнее использовать 301 редирект везде, где это только возможно.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003e301 редирект или rel=«canonical»?\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eДавайте определим, какой способ и когда лучше использовать.\u003c/p\u003e\u003cp\u003e301 редирект лучше:\u003c/p\u003e\u003cp\u003e1. Просто по умолчанию. Это более предпочтительный метод вследствие того, что rel=«canonical» не всегда обрабатывается корректно.\u003c/p\u003e\u003cp\u003e2. Если у страницы навсегда изменился адрес.\u003c/p\u003e\u003cp\u003e3. Если сайт переехал на новый домен.\u003c/p\u003e\u003cp\u003e4. Если администратор сайта удалил какую-то страницу, но вместо 404 ошибки хочет показать пользователям другую, схожую с удаленной, информацию (например, другой товар взамен удаленного).\u003c/p\u003e\u003cp\u003erel=«canonical» лучше:\u003c/p\u003e\u003cp\u003e1. Когда 301 редирект не может быть реализован или его внедрение потребует слишком больших затрат.\u003c/p\u003e\u003cp\u003e2. Когда имеет смысл показывать частично дублированный контент пользователям. Например, несколько страниц стола с разной длиной столешницы можно показывать в расчете на более высокую конверсию, особенно если на эти страницы ведут специальные объявления из систем контекстной рекламы.\u003c/p\u003e\u003cp\u003e3. Когда нужно показывать страницы с почти одинаковым содержимым (например, сортировки каталога, отслеживания партнерских ссылок).\u003c/p\u003e\u003cp\u003e4. Для кросс-доменов, когда оба сайта похожи, но похожий контент нужно оставить на каждом из доменов. Эта ситуация может быть опасна из-за аффилирования, о чем мы поговорим в разделе, посвященном санкциям поисковых систем.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eОшибки при использовании редиректов\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eЗакрывая тему редиректов, хочется рассказать об ошибках, которых стоит избегать:\u003c/p\u003e\u003cp\u003e1. Необходимо делать правильный выбор между 301 редиректом и rel=«canonical».\u003c/p\u003e\u003cp\u003e2. Нужно избегать любых многошаговых редиректов. Одношаговый редирект быстрее работает и сохраняет максимум ссылочного веса. Кроме того, если на сайте будут замечены многошаговые редиректы, поисковая система может решить, что ваша страница – дорвей. А это повлечет серьезнейшие санкции для сайта.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e✍ \u003cstrong\u003e\u003cem\u003eНа заметку\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eДорвей\u003c/em\u003e\u003c/strong\u003e[36]\u003cstrong\u003e\u003cem\u003e (от англ. doorway – входная дверь, портал) или входная страница, – один из видов поискового спама. Это веб-страница, специально оптимизированная под один или несколько поисковых запросов с целью ее проникновения на высокие места в результатах поиска и дальнейшего перенаправления посетителей на другой сайт или страницу.\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eДорвей не представляет никакой ценности, и пользователь даже не успевает его рассмотреть – его сразу перенаправляют на другой сайт. Контент дорвея, как правило, лишен смысла и генерируется автоматически по специальным алгоритмам (писать руками слишком затратно). Часто это просто набор фраз, в который внедрены ключевые слова.\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eДорвеи – это веб-мусор, поэтому все поисковые машины беспощадно с ними борются.\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e3. Нужно применять правильные виды редиректов[37], чтобы не запутать поискового робота.\u003c/p\u003e\u003cp\u003e4. При внедрении редиректа необходимо позаботиться о том, чтобы на сайте не осталось ссылок со старым URL-адресом (с которого и выполняется перенаправление).\u003c/p\u003e\u003cp\u003e5. Редирект желательно ставить на максимально релевантную страницу. Например, на похожую карточку товара или ветку каталога, к которому принадлежала страница. Если это невозможно, лучше выдавать 404 ошибку, о которой мы поговорим чуть позже.\u003c/p\u003e\u003cp\u003e6. Редирект должен вести на действующую страницу (с кодом ответа 200 ОК). Иначе нужно вернуть 404 ошибку.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eRobots.txt\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eRobots.txt – это специальный служебный файл, расположенный в корневом каталоге сайта[38], который является незаменимым помощником в борьбе с дублями и нецелевыми страницами, попавшими в индекс. Следует обязательно создать этот файл в соответствии с рекомендациями поисковых систем[39], а затем указать в нем страницы и данные, которые поисковым роботам не следует индексировать.\u003c/p\u003e\u003cp\u003eПеречислим типичные разделы и страницы с дублированным контентом, индексацию которых стоит запретить в файле robots.txt:\u003c/p\u003e\u003cp\u003e– страницы фильтраций и сортировок с дублированным контентом;\u003c/p\u003e\u003cp\u003e– страницы с UTM-метками;\u003c/p\u003e\u003cp\u003e– результаты поиска;\u003c/p\u003e\u003cp\u003e– тестовые страницы, поддомены и серверы;\u003c/p\u003e\u003cp\u003e– RSS-фиды.\u003c/p\u003e\u003cp\u003eВ файл также следует добавить разделы с малоинформативным и служебным контентом:\u003c/p\u003e\u003cp\u003e– служебные страницы и файлы, логи сайта, страницы с внутренней статистикой, вход в административную панель, кэш страниц, подгружаемые модули и другие технические страницы;\u003c/p\u003e\u003cp\u003e– страницы авторизации, смены и напоминания пароля;\u003c/p\u003e\u003cp\u003e– «висячие узлы», то есть страницы, с которых нет ссылок на другие страницы сайта (например, версия страницы для печати);\u003c/p\u003e\u003cp\u003e– страницы совершения действия (добавления в корзину, оформления заказа и прочее);\u003c/p\u003e\u003cp\u003e– страницы с динамическими параметрами[40];\u003c/p\u003e\u003cp\u003e– неинформативные или пустые doc- и pdf-файлы (такие файлы лучше не просто закрывать от индексации, а удалять с сайта). При этом надо помнить, что, если такие файлы уникальны и несут полезную информацию, их не закрывают от индексации.\u003c/p\u003e\u003cp\u003eПриведенные списки не являются исчерпывающими. Каждый движок имеет свои особенности, поэтому желательно делать регулярную проверку, выявлять дубли и «мусорные» страницы и запрещать их к индексации.\u003c/p\u003e\u003cp\u003eНадо отметить, что запрещение индексации разделов через файл robots.txt без скрытия ссылок на них может приводить к тому, что эти разделы все же попадут в индекс со всеми вытекающими последствиями.\u003c/p\u003e\u003cp\u003eПро robots.txt профессионалы даже шутят, что он как презерватив: вроде бы защищает, но гарантий никаких.\u003c/p\u003e\u003cp\u003eПоэтому желательно просто убирать ссылки на нежелательные разделы из клиентской части сайта: так вы надежно скроете их и от поисковых роботов, и от пользователей.\u003c/p\u003e\u003cp\u003eВ файле robots.txt следует указать ссылку на карту сайта с помощью директивы Sitemap[41].\u003c/p\u003e\u003cp\u003eОстается добавить, что для анализа корректности файла robots.txt нужно воспользоваться валидаторами поисковых систем[42].\u003c/p\u003e\u003c/section\u003e\u003csection\u003e\u003ch3\u003e\u003cp\u003e11. Оптимизация заголовков\u003c/p\u003e\u003c/h3\u003e\u003cp\u003eПри оптимизации заголовков встречается много ошибок. Давайте разберем типичные недостатки и поймем, как их избежать.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eЗаголовок hl\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eСогласно многим исследованиям, заголовок h1[43] зачастую работает как «второй тайтл», поэтому к нему нужно относиться максимально внимательно:\u003c/p\u003e\u003cp\u003e1. Заголовок h1 единожды должен присутствовать на каждой странице сайта. Повторное использование тегов заголовка h1 на странице недопустимо.\u003c/p\u003e\u003cp\u003e2. Заголовок должен «перекликаться» с тегом \u003ctitle\u003e, допускается частичное или даже полное дублирование.\u003c/p\u003e\u003cp\u003e3. Заголовок должен однозначно визуально идентифицироваться на странице, чтобы пользователь сразу понимал содержание текущего раздела. Добиться выделения заголовка можно с помощью размера букв, шрифта, цвета и других приемов.\u003c/p\u003e\u003cp\u003e4. В теле заголовка желательно использовать ключевые слова, но переоптимизация (чрезмерное употребление) недопустима.\u003c/p\u003e\u003cbr/\u003e\u003cdiv style=\"text-align: center\"\u003e\u003cimg src=\"/img/58535581/i_004.jpg\"\u003e\u003c/img\u003e\u003c/div\u003e\u003cp\u003e\u003cstrong\u003eРис. 3. Сайт htmlbook.ru – полезный справочник для любого вебспециалиста\u003c/strong\u003e\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eТеги h2-h6\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eПеречислим основные рекомендации, которые помогут правильно применять второстепенные заголовки:\u003c/p\u003e\u003cp\u003e1. Заголовки пришли в Интернет со страниц газетных полос и по возможности должны следовать газетной традиции визуального оформления: h1 должен быть самым крупным и заметным, h2 – меньше, h3 – еще мельче. Так пользователь сможет легче понять иерархию текста на странице.\u003c/p\u003e\u003cp\u003e2. Оптимально использовать только теги h1-h3. Теги h4-h6 почти бесполезны для поискового продвижения, а их использование свидетельствует о проблемах с текстом на странице: он слишком подробно поделен на отдельные части и его необходимо сделать более однородным. Для больших информационных порталов (словарей, справочников и т. п.) допускается также использование h4. Теги h5-h6 лучше не использовать никогда.\u003c/p\u003e\u003cp\u003e3. Ключевые слова в заголовках h2 и h3 могут быть слабым сигналом релевантности, поэтому этим надо пользоваться. Нужно размещать ключевые слова в этих элементах, но не во всех, так как это может быть признаком текстовой переоптимизации, за которую поисковые системы наложат на страницу санкции.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eТипичные ошибки\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eПеречислим типичные ошибки, которых следует избегать:\u003c/p\u003e\u003cp\u003e1. Тегами заголовков можно выделять только заголовки в контентной (текстовой) части страницы. Другие варианты их применения в верстке недопустимы.\u003c/p\u003e\u003cp\u003eДля оформления контента вне основной области страницы (шапка, левая/правая колонка, подвал сайта) можно создать и использовать специальные css-классы.\u003c/p\u003e\u003cp\u003e2. По возможности нужно стараться делать код заголовков более «чистым», без дополнительных тегов и классов. Идеально: \u003cй1\u003eТекст заголовка\u003c /h1\u003e. Это не влияет на продвижение сайта, но поможет придерживаться единого стиля заголовков на всем сайте.\u003c/p\u003e\u003cp\u003e3. Не следует перебарщивать с количеством подзаголовков h2 и h3 на странице. Их количество должно быть адекватно количеству текста (в среднем – один подзаголовок на 800-1500 символов).\u003c/p\u003e\u003cp\u003eПомимо технических задач, связанных с продвижением, заголовки играют большую роль в удержании пользователей и повышении конверсии. Эти аспекты мы подробно разберем в соответствующих разделах.\u003c/p\u003e\u003c/section\u003e\u003csection\u003e\u003ch3\u003e\u003cp\u003e12. Настройка адресации\u003c/p\u003e\u003c/h3\u003e\u003cp\u003eПравильная адресация помогает пользователям ориентироваться на сайте и способствует повышению позиций сайта в поисковой выдаче. Ее необходимо оптимизировать на самом раннем этапе работ, иначе можно потерять часть уже достигнутых при продвижении результатов.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eЧПУ\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eКак известно, к сайту можно обратиться по его URL[44]. URL (англ. Uniform Resource Locator, «урл») – это единый указатель (адрес) ресурса. URL служит стандартизированным способом записи адреса ресурса в Интернете.\u003c/p\u003e\u003cp\u003eВсе без исключения страницы сайта должны иметь человеко-понятный урл (ЧПУ). Так на профессиональном жаргоне называют веб-адрес, содержащий читаемые слова вместо служебных параметров, более удобных для компьютера, чем для людей (например, числовых идентификаторов страницы).\u003c/p\u003e\u003cp\u003eТакой адрес состоит из букв латинского (английского) алфавита, цифр и знака «-» (дефиса), который используется для отделения слов друг от друга вместо пробела. ЧПУ отражает виртуальную иерархическую структуру сайта (физически такая структура папок и файлов на сервере может и не существовать). Пример такого адреса: http://site.ru/katalog/igrushki/kubik-rubika\u003c/p\u003e\u003cp\u003eВ Гугле такие адреса называют простыми[45]. И действительно, чтобы добиться такой адресации, структуру сайта нужно делать предельно простой, логичной и понятной. Это поможет пользователям просматривать сайт, а роботам – правильно его индексировать.\u003c/p\u003e\u003cp\u003eЧПУ должен дублировать структуру сайта. Вот примеры того, как он должен выглядеть для разных разделов:\u003c/p\u003e\u003cp\u003e– [главная страница]\u003c/p\u003e\u003cp\u003e– [главная страница] + [раздел]\u003c/p\u003e\u003cp\u003e– [главная страница] + [раздел] + [подраздел]\u003c/p\u003e\u003cp\u003e– [главная страница] + [раздел] + [подраздел] + [страница]\u003c/p\u003e\u003cp\u003eПриведем простой алгоритм образования URL-адреса из заголовка страницы. Это оптимальный способ автоматического формирования ЧПУ, но важно соблюдать последовательность действий:\u003c/p\u003e\u003cp\u003e1. Преобразовать строку заголовка страницы в нижний регистр.\u003c/p\u003e\u003cp\u003e2. Заменить символы кириллицы согласно таблице ниже.\u003c/p\u003e\u003cbr/\u003e\u003cdiv style=\"text-align: center\"\u003e\u003cimg src=\"/img/58535581/i_005.png\"\u003e\u003c/img\u003e\u003c/div\u003e\u003cbr/\u003e\u003cp\u003e1. Все символы, кроме допустимых (знака тире, букв и цифр), заменить на «-» (включая пробел). Регулярное выражение для замены [^-a-zQ-9].\u003c/p\u003e\u003cp\u003e2. Заменить несколько идущих подряд «-» на один «-».\u003c/p\u003e\u003cp\u003e3. Проверить и удалить, в случае необходимости, символ «-» на первой и последней позиции в строке.\u003c/p\u003e\u003cp\u003e4. К полученному результату слева присоединить косую черту и ЧПУ раздела, находящегося на один уровень выше текущего. Понятно, что самым верхним уровнем будет домен сайта.\u003c/p\u003e\u003cp\u003eДля проверки качества ЧПУ можно провести простой тест: дать контрольной группе пользователей только URL-адрес нескольких разделов сайта и попросить описать, чему посвящены эти страницы. Если у них возникнут проблемы – стоит внести коррективы.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eВажные замечания\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eСпам. \u003c/strong\u003eЧПУ не должен быть заспамлен, то есть в нем не должно быть слишком много ключевых слов (тем более они не должны повторяться!). Если ЧПУ формируется из заголовка, то сначала необходимо оптимизировать заголовки согласно ранее данным рекомендациям.\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eДлина. \u003c/strong\u003eURL-адрес должен быть коротким. Хорошим тоном считается удерживать длину адреса в пределах 150–200 символов. Это удобно для пользователей и радует поисковых роботов.\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eКлючевые слова. \u003c/strong\u003eВ адресе обязательно нужно использовать ключевые слова. Это не только поможет пользователям лучше понимать структуру адресов сайта, но и может улучшить кликабельность на странице поисковой выдачи, так как ключевые слова там выделяются жирным шрифтом.\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eПодразделы вместо поддоменов. \u003c/strong\u003eБез крайней необходимости не стоит выносить контент за пределы основного домена сайта (на поддомены).\u003c/p\u003e\u003cp\u003eВ общем случае домен и его поддомен поисковыми системами воспринимаются как два разных сайта. Соответственно, если весь контент агрегируется на основном домене, можно получить синергетический эффект при продвижении за счет роста размера сайта, ссылочной массы и поведенческой статистики. Если вынести часть контента на поддомены, в общем случае вместо одного «сильного» сайта получится несколько «слабых», которые даже в совокупности будут генерировать гораздо меньше трафика.\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eНижний регистр. \u003c/strong\u003eВсе URL должны быть в нижнем регистре. Если на сайте использовался верхний регистр, нужно настроить 301 редирект на страницы в нижнем регистре.\u003c/p\u003e\u003c/section\u003e\u003csection\u003e\u003ch3\u003e\u003cp\u003e13. Файл Sitemap.xml\u003c/p\u003e\u003c/h3\u003e\u003cp\u003eSitemap.xml – это служебный файл[46] карты сайта в формате XML[47], который позволяет сообщить поисковым системам информацию о том, как организованы данные на продвигаемом вебресурсе. В нем содержатся ссылки на все разделы и страницы, которые должны быть проиндексированы поисковыми роботами.\u003c/p\u003e\u003cp\u003eКак правило, sitemap.xml на больших или часто изменяющихся сайтах генерируется на лету (этот процесс легко автоматизировать). Реальный адрес файла вовсе не обязан быть site. ru/sitemap.xml: он может быть абсолютно любым, например, site.com/anything (хотя лучше, конечно, чтобы у карты сайта был осмысленный адрес).\u003c/p\u003e\u003cp\u003eПоисковые роботы регулярно скачивают файл карты сайта, сравнивают его с имеющейся у них версией и, если файлы отличаются (например, в скачанной версии добавились новые ссылки), индексируют изменения на сайте.\u003c/p\u003e\u003cp\u003eПомимо новых ссылок, файлы Sitemap помогают передать поисковику метаданные о страницах сайта. Например, можно указать дату последнего изменения, периодичность обновления контента и важность страницы на сайте по сравнению с другими разделами.\u003c/p\u003e\u003cp\u003eСуществуют отдельные виды файлов для разных типов контента, включая видео[48] и изображения[49]. Для абсолютного большинства веб-проектов генерировать их нет смысла, но, если для продвигаемого проекта это актуально, рекомендуется разработать в движке функционал, позволяющий автоматически генерировать и обновлять соответствующие документы.\u003c/p\u003e\u003cbr/\u003e\u003cp\u003e\u003cstrong\u003e\u003cem\u003eНеобходимость файла sitemap.xml\u003c/em\u003e\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eНекоторые исследователи придерживаются мнения, что файл sitemap.xml не нужен для большинства сайтов. Якобы структуру веб-ресурса нужно делать настолько простой и удобной, чтобы поисковые роботы смогли без проблем добраться до любой страницы сайта и проиндексировать ее. Такая структура гораздо лучше подходит не только для поисковиков, но и для пользователей. Им становится проще пользоваться сайтом, что улучшает поведенческие факторы ранжирования (например, количество и глубину переходов, время на сайте).\u003c/p\u003e\u003cp\u003eИсключение составляют масштабные информационные и e-commerce проекты, где просто-напросто слишком много страниц, и сделать их все относительно легкодоступными не всегда представляется возможным.\u003c/p\u003e\u003cp\u003eС тем, что структуру ресурса нужно делать удобной, никто не спорит (подробнее мы поговорим об этом в главе про структурную оптимизацию сайта). И действительно, если страницы сайта корректно и полно связаны друг с другом, поисковый робот сможет рано или поздно обнаружить все материалы. Однако это не отменяет необходимости настраивать sitemap.xml для всех сайтов.\u003c/p\u003e\u003cp\u003eSitemap.xml является слабым сигналом качества сайта и повышает уровень траста сайта. Даже для небольших проектов он способен помочь поисковым роботам более точно и оперативно индексировать все изменения на сайте.\u003c/p\u003e\u003cp\u003eКроме того, файл карты сайта однозначно нужен, если:\u003c/p\u003e"},"reviews":{"total_count":0,"page":1,"page_size":5,"data":[]},"pageNumber":"3","_sentryTraceData":"7e21382b642d49f7a6097afafcb6b8b6-85d0f278637d4f28-0","_sentryBaggage":"sentry-environment=production,sentry-release=U2uZjhPRDs9JIyGm6wBTG,sentry-public_key=849376fd4c2a49839df4f34bdf204e56,sentry-trace_id=7e21382b642d49f7a6097afafcb6b8b6,sentry-sample_rate=0.05,sentry-transaction=%2Fonline%2F%5Bid%5D%2F%5BpageNumber%5D,sentry-sampled=false"},"__N_SSP":true},"page":"/online/[id]/[pageNumber]","query":{"id":"529375","pageNumber":"3"},"buildId":"U2uZjhPRDs9JIyGm6wBTG","isFallback":false,"isExperimentalCompile":false,"gssp":true,"scriptLoader":[]}</script></body></html>