Полная версия

Алгоритмы машинного обучения: базовый курс

4. Проекция данных: теперь можно проецировать исходные данные на найденные компоненты. Это преобразует данные в новое пространство меньшей размерности.

Пример использования PCA

Допустим, у нас есть набор данных с множеством признаков, и мы хотим уменьшить их количество, чтобы улучшить производительность модели. Рассмотрим следующий пример с использованием библиотеки scikit-learn на Python.

Пример: применение PCA на данных о цветах ирисов

В этом примере мы будем работать с известным набором данных Iris. Данные содержат информацию о 4 признаках для каждого из 150 цветов ирисов (длина и ширина чашелистика и лепестка). Мы будем использовать PCA, чтобы уменьшить размерность до 2-х компонентов для визуализации.

```python

# Импортируем необходимые библиотеки

import numpy as np

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

from sklearn.preprocessing import StandardScaler

# Загружаем набор данных Iris

iris = load_iris()

X = iris.data # Признаки

y = iris.target # Метки классов

# Масштабируем данные

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# Применяем PCA для уменьшения размерности до 2

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X_scaled)

# Визуализируем данные

plt.figure(figsize=(8, 6))

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y, cmap='viridis')

plt.title("PCA на данных о цветах ирисов")

plt.xlabel("Первая главная компонента")

plt.ylabel("Вторая главная компонента")

plt.colorbar(label='Метка класса')

plt.show()

# Смотрим долю объясненной дисперсии

print("Доля объясненной дисперсии для каждой компоненты:", pca.explained_variance_ratio_)

print("Общая объясненная дисперсия (для 2 компонент):", np.sum(pca.explained_variance_ratio_))

```

Объяснение кода:

1. Загрузка данных: Мы загружаем стандартный набор данных Iris, который содержит 4 признака (длина и ширина чашелистика и лепестка) для 150 цветов ирисов.

2. Масштабирование данных: Признаки масштабируются, чтобы все признаки имели одинаковый масштаб (среднее значение 0 и стандартное отклонение 1). Это важно для PCA, так как этот метод чувствителен к масштабу данных.

3. Применение PCA: Мы используем PCA для уменьшения размерности с 4 до 2 компонент. Это позволяет нам визуализировать данные в двумерном пространстве.

4. Визуализация: Рисуем график, где каждая точка представляет один ирис, и цвет указывает на класс (вид ириса).

5. Доля объясненной дисперсии: Мы выводим долю дисперсии, которую объясняют главные компоненты. Чем выше эта доля, тем больше информации сохраняется при уменьшении размерности.

Результат:

После выполнения этого кода мы получим график, на котором ирисы будут разделены по двум главным компонентам. Эти компоненты объясняют основную вариативность данных, и благодаря снижению размерности мы можем легко визуализировать данные. Также, мы увидим, как хорошо первые две компоненты объясняют дисперсию данных (обычно они объясняют большую часть информации).

Преимущества и ограничения PCA

Преимущества:

– Ускорение обработки: Уменьшение размерности позволяет быстрее обучать модели.

– Снижение переобучения: Уменьшение количества признаков помогает избежать переобучения, так как модель фокусируется на более значимых признаках.

– Визуализация: Снижение размерности позволяет визуализировать многомерные данные, что важно для анализа и принятия решений.

Ограничения:

– Потеря информации: Хотя PCA сохраняет максимально возможную информацию, всегда существует некоторая потеря информации при уменьшении размерности.

– Линейность: PCA – линейный метод, и если данные имеют сложные, нелинейные зависимости, то PCA может не дать хороших результатов.

PCA – это инструмент для уменьшения размерности данных, который позволяет упростить модели, улучшить визуализацию и снизить коллинеарность признаков. Этот метод широко используется в различных областях, от анализа данных до машинного обучения, и помогает справляться с большими и высокоразмерными наборами данных.

Пример: Сегментация данных с использованием PCA на наборе данных о клиентах

Для этого примера давайте рассмотрим задачу сегментации клиентов, используя набор данных о покупательских привычках. Мы будем использовать PCA для снижения размерности, а затем применим алгоритм K-means для кластеризации. В данном случае данные будут включать различные характеристики клиентов, такие как сумма покупок и частота покупок. Задача состоит в том, чтобы разделить клиентов на группы с похожими покупательскими привычками.

Мы будем использовать сконструированный набор данных, который включает два признака:

– Сумма покупок: сколько клиент тратит за месяц.

– Частота покупок: как часто клиент делает покупки в месяц.

Цель – сегментировать клиентов на основе этих признаков.

Шаг 1: Генерация данных

Для начала создадим искусственные данные с использованием библиотеки `numpy`. Мы сгенерируем данные с 2 признаками для 300 клиентов и будем использовать PCA для уменьшения размерности, а затем применим K-means для сегментации.

```python

import numpy as np

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

from sklearn.datasets import make_blobs

# Генерация искусственного набора данных

np.random.seed(42)

# Создадим два кластера с различной суммой покупок и частотой покупок

X, _ = make_blobs(n_samples=300, centers=[[10, 5], [60, 15]], cluster_std=[15, 15], random_state=42)

# Масштабируем данные

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# Визуализируем исходные данные

plt.scatter(X_scaled[:, 0], X_scaled[:, 1], alpha=0.5)

plt.title("Изначальные данные о покупках")

plt.xlabel("Сумма покупок")

plt.ylabel("Частота покупок")

plt.show()

```

Шаг 2: Применение PCA для снижения размерности

Хотя наши данные уже имеют всего два признака, на реальных данных размерность может быть гораздо выше. В этом случае PCA поможет нам снизить размерность, например, до двух компонент для визуализации и дальнейшего анализа.

```python

# Применяем PCA для уменьшения размерности

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X_scaled)

# Визуализируем данные после PCA

plt.scatter(X_pca[:, 0], X_pca[:, 1], alpha=0.5)

plt.title("Данные после PCA")

plt.xlabel("Первая главная компонента")

plt.ylabel("Вторая главная компонента")

plt.show()

```

Шаг 3: Применение K-means для кластеризации

Теперь, когда мы применили PCA для снижения размерности, можно использовать алгоритм K-means для сегментации данных. Для этого мы заранее определим количество кластеров, например, 2, так как мы знаем, что данные состоят из двух групп клиентов.

```python

# Применяем K-means для кластеризации

kmeans = KMeans(n_clusters=2, random_state=42)

y_kmeans = kmeans.fit_predict(X_pca)

# Визуализируем результаты кластеризации

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y_kmeans, cmap='viridis', alpha=0.5)

plt.scatter(kmeans.cluster_centers_[:, 0], kmeans.cluster_centers_[:, 1], s=200, c='red', marker='X', label='Центроиды')

plt.title("Результаты кластеризации K-means")

plt.xlabel("Первая главная компонента")

plt.ylabel("Вторая главная компонента")

plt.legend()

plt.show()

```

Шаг 4: Анализ результатов

После выполнения этих шагов мы получим два кластера, которые будут представлены на графике с различными цветами. Красные крестики на графике показывают центроиды кластеров. Эти центроиды представляют собой средние значения для каждого из кластеров.

Шаг 5: Проверка объяснённой дисперсии с помощью PCA

Для того чтобы понять, насколько эффективно мы сохранили информацию при уменьшении размерности, можно проверить, сколько дисперсии данных объясняется выбранными компонентами. В случае с нашим набором данных, PCA должен хорошо сохранить информацию, так как мы работаем с низким числом признаков.

```python

# Выводим долю объясненной дисперсии для каждой главной компоненты

print("Доля объясненной дисперсии для каждой компоненты:", pca.explained_variance_ratio_)

print("Общая объясненная дисперсия (для 2 компонент):", np.sum(pca.explained_variance_ratio_))

```

Результат:

1. Визуализация после применения PCA: После применения PCA мы видим данные, упорядоченные вдоль двух главных компонент. Хотя у нас всего два исходных признака, PCA позволяет выразить данные в линейной комбинации этих признаков, что помогает выделить важные закономерности.

2. Кластеризация с K-means: После применения K-means мы получаем два кластера клиентов. Это позволяет сегментировать клиентов на группы с схожими покупательскими привычками, что может быть полезно для таргетированной маркетинговой кампании.

3. Объяснённая дисперсия: Ожидаемая доля объяснённой дисперсии поможет понять, сколько информации мы потеряли при применении PCA. В случае с двумя компонентами результат обычно будет достаточно высоким, особенно для данных с явными группами.

В этом примере мы использовали PCA для снижения размерности данных о покупках клиентов и применили алгоритм K-means для сегментации этих клиентов. Этот подход можно использовать для более сложных задач, когда данные имеют много признаков, и важно выявить скрытые группы в данных. PCA позволяет уменьшить размерность без значительных потерь информации, а K-means помогает легко и быстро сегментировать клиентов на основе основных признаков.

Сегментация данных с помощью методов снижения размерности и кластеризации является важным инструментом в бизнес-аналитике, маркетинге и других областях, где необходимо разделить данные на группы с похожими характеристиками для дальнейшего анализа или принятия решений.

Глава 6. Полусупервизорное и обучение с подкреплением

– Принципы обучения с подкреплением

– Q-Learning: примеры и применение

– Полусупервизорные подходы

В этой главе мы рассмотрим два мощных подхода в области машинного обучения, которые открывают новые возможности для решения сложных задач: обучение с подкреплением и полусупервизорное обучение.

Обучение с подкреплением включает в себя процесс, при котором агент взаимодействует с окружающей средой и учится на основе получаемой обратной связи в виде награды или наказания. Этот подход становится все более популярным в решении задач, где важен процесс принятия решений и стратегия, направленная на достижение долгосрочных целей, таких как в играх, робототехнике или даже в оптимизации бизнес-процессов.

Полусупервизорные методы являются промежуточным решением между супервизорным и несупервизорным обучением. В ситуациях, когда есть большое количество неразмеченных данных и небольшое количество размеченных, полусупервизорные подходы позволяют эффективно использовать все данные, улучшая результаты модели с меньшими затратами на разметку.

В этой главе мы углубимся в эти методы, разберем их принципы, области применения и примеры реализации, что позволит понять, как и когда можно применить их для решения реальных задач.

Основные принципы обучения с подкреплением

Обучение с подкреплением (reinforcement learning, RL) – это подход в машинном обучении, при котором агент учится принимать решения, взаимодействуя с окружающей средой и получая за свои действия обратную связь в виде награды или наказания. Этот процесс напоминает обучение через опыт: агент предпринимает действия в определённой среде, получает результаты этих действий и на основе этих результатов корректирует свои дальнейшие действия.

Основной идеей в обучении с подкреплением является то, что агент должен максимизировать свою долгосрочную награду. Агент не получает четких указаний о том, какие действия он должен выполнять, а лишь получает информацию о том, насколько успешными были его действия на основе полученной награды. Это делает обучение с подкреплением схожим с процессом обучения живых существ: они учат свои действия через опыт, получая позитивные или негативные последствия в зависимости от того, насколько правильными были их выборы.

Процесс обучения с подкреплением можно описать через несколько ключевых компонентов. Агент – это существо или система, которая принимает решения и взаимодействует с окружающей средой. Среда, в свою очередь, представляет собой всё, с чем агент взаимодействует, включая её состояние. Каждое состояние среды – это описание текущего положения дел, и агент на основе этого состояния решает, какое действие он должен предпринять.

Когда агент выбирает действие, среда реагирует, изменяя своё состояние, и агент получает награду или наказание в зависимости от того, как полезным было это действие для достижения цели. Награда – это числовая величина, которая отражает степень успеха действия агента, а цель агента заключается в том, чтобы в долгосрочной перспективе накопить как можно больше награды. Это позволяет агенту научиться, какие действия в каких ситуациях приводят к наибольшей выгоде.

Одной из важнейших проблем обучения с подкреплением является баланс между исследованием (exploration) и эксплуатацией (exploitation). Исследование заключается в том, чтобы пробовать новые действия, которые могут привести к более высоким наградам, даже если они не гарантируют немедленного успеха. Эксплуатация – это использование уже известных и успешных действий, которые обеспечивают более предсказуемый результат. Баланс между этими двумя подходами критичен, так как слишком большое количество исследования может привести к неэффективности, а слишком много эксплуатации – к застою и пропущенным возможностям для улучшения.

Для того чтобы агент мог учиться, ему нужно понимать, какие действия в каком состоянии среды приводят к наибольшей награде. Это связано с понятием "политики" (policy), которая представляет собой стратегию поведения агента: она определяет, какое действие должен выполнить агент в каждом возможном состоянии. Политика может быть детерминированной, когда для каждого состояния есть однозначное действие, или стохастической, когда агент с определённой вероятностью выбирает одно из нескольких возможных действий.

Обучение с подкреплением также связано с понятием "ценности" (value). Агент не всегда может сразу оценить, насколько выгодно его текущее состояние, но он может оценить будущее состояние, которое он надеется достичь, используя стратегию и получая награды за свои действия. Оценка ценности связана с идеей того, насколько хорошо будет обрабатывать агент своё будущее.

Обучение с подкреплением позволяет моделировать сложные процессы принятия решений, в которых не существует явных указаний, а правильное поведение должно быть выведено через эксперименты и опыт. Такие системы могут быть использованы в самых различных областях, от игр и робототехники до финансового анализа и маркетинга.

Давайте рассмотрим обучение с подкреплением на примере с использованием Python и библиотеки `gym`, которая предоставляет множество стандартных сред для тренировки алгоритмов обучения с подкреплением.

Мы будем использовать классический пример – задачу "CartPole", где цель состоит в том, чтобы агент удерживал столбик (cart) в вертикальном положении как можно дольше, балансируя на колесе, двигая его влево или вправо.

Шаг 1: Установка и импорт библиотек

Для начала установим нужные библиотеки. В случае использования Google Colab или Jupyter, это можно сделать через команду:

```bash

pip install gym

```

Затем импортируем все необходимые компоненты.

```python

import gym

import numpy as np

import random

import matplotlib.pyplot as plt

```

Шаг 2: Создание среды

Теперь создадим среду CartPole с помощью библиотеки `gym`.

```python

# Создаем среду

env = gym.make('CartPole-v1')

```

Шаг 3: Определение агента

В обучении с подкреплением важным моментом является создание агента, который будет принимать решения, основываясь на текущем состоянии среды. Агент должен выбрать действие на основе текущего состояния. Для простоты давайте реализуем случайный агент, который будет случайным образом выбирать действия, чтобы исследовать пространство.

```python

# Инициализация состояния среды

state = env.reset()

# Действия агента: 0 – двигаться влево, 1 – двигаться вправо

actions = [0, 1]

# Количество шагов

num_steps = 200

# Суммарная награда

total_reward = 0

# Сеанс игры с случайным агентом

for _ in range(num_steps):

action = random.choice(actions) # случайный выбор действия

next_state, reward, done, _, _ = env.step(action) # Выполняем действие

total_reward += reward

state = next_state # Переход к следующему состоянию

# Если агент упал (закончилась игра), завершаем

if done:

break

# Выводим итоговую награду

print(f"Total Reward: {total_reward}")

```

Этот код показывает, как агент взаимодействует с средой, выбирает действия и накапливает награды. Но такой агент не обучается, он просто случайно выполняет действия, что делает его неэффективным. Нам нужно сделать так, чтобы агент обучался и максимизировал свои награды.

Шаг 4: Алгоритм Q-learning

Q-learning – это один из популярных методов обучения с подкреплением, который помогает агенту учиться на основе награды, которую он получает за выполнение определённого действия в каждом состоянии. Агент заполняет таблицу значений Q (ценности состояния-действия), которая описывает, насколько выгодно выполнить действие в конкретном состоянии.

Мы начнем с создания таблицы Q для всех состояний и действий. Сначала пространство состояний среды CartPole сильно большое и непрерывное, поэтому нам нужно будет дискретизировать его, чтобы работать с таблицей Q.

Шаг 5: Реализация алгоритма Q-learning

Пример реализации алгоритма Q-learning для задачи CartPole:

```python

# Устанавливаем параметры

learning_rate = 0.1 # Скорость обучения

discount_factor = 0.99 # Дисконтирование будущих наград

epsilon = 0.1 # Вероятность выбора случайного действия (исследование)

num_episodes = 1000 # Количество эпизодов обучения

# Инициализация Q-таблицы

# Преобразуем состояния в дискретные

def discretize_state(state):

discrete_state = [

int(state[0] // 0.1),

int(state[1] // 0.1),

int(state[2] // 0.1),

int(state[3] // 0.1)

]

return tuple(discrete_state)

# Размеры Q-таблицы (по оси состояния и действия)

q_table = np.zeros((6, 6, 6, 6, env.action_space.n)) # для CartPole (4 признака, 2 действия)

# Функция для выбора действия с учётом epsilon-greedy стратегии

def epsilon_greedy(state):

if random.uniform(0, 1) < epsilon:

return random.choice([0, 1]) # Случайный выбор

else:

return np.argmax(q_table[state]) # Лучшее действие по таблице Q

# Обучение агента

for episode in range(num_episodes):

state = discretize_state(env.reset()) # Начальное состояние, дискретизация

done = False

total_reward = 0

while not done:

action = epsilon_greedy(state) # Выбор действия

next_state, reward, done, _, _ = env.step(action) # Выполнение действия

next_state = discretize_state(next_state) # Дискретизация следующего состояния

# Обновление Q-значения по формуле Q-learning

q_table[state][action] = q_table[state][action] + learning_rate * (

reward + discount_factor * np.max(q_table[next_state]) – q_table[state][action]

)

state = next_state # Переход к новому состоянию

total_reward += reward

if episode % 100 == 0:

print(f"Episode {episode}/{num_episodes}, Total Reward: {total_reward}")

```

Шаг 6: Тестирование обученного агента

После того как агент обучился с использованием Q-learning, мы можем протестировать его эффективность. В тестировании агент будет следовать стратегии, основанной на максимизации ценности действия, и применять её без случайных выборов.

```python

# Тестирование агента

state = discretize_state(env.reset())

done = False

total_reward = 0

while not done:

action = np.argmax(q_table[state]) # Лучшее действие по таблице Q

next_state, reward, done, _, _ = env.step(action)

state = discretize_state(next_state) # Дискретизация следующего состояния

total_reward += reward

print(f"Total Reward in test: {total_reward}")

```

Результаты

Во время обучения агент постепенно улучшает свою стратегию. Сначала он может случайным образом двигать столбик, но с течением времени, когда он получает обратную связь в виде награды, он начинает находить более эффективные действия, чтобы удерживать столбик в вертикальном положении.

После завершения обучения агент должен показывать значительно более высокие результаты, чем в начале, когда он выбирал действия случайным образом.

Этот пример демонстрирует, как с помощью обучения с подкреплением можно обучить агента действовать в динамической среде, такой как CartPole. Метод Q-learning позволяет агенту улучшать свою стратегию со временем, учась на опыте, получая награды и корректируя свои действия, чтобы максимизировать долгосрочную награду.

Q-Learning

Q-Learning – это один из наиболее популярных и широко используемых алгоритмов в области обучения с подкреплением. Этот метод используется для поиска оптимальной стратегии или политики, позволяя агенту выбирать лучшие действия для максимизации долгосрочной награды.

Основная цель Q-learning заключается в том, чтобы для каждого состояния и действия агент находил ценность (Q-значение), которое описывает, насколько выгодно выполнить определённое действие в конкретном состоянии. Эти Q-значения обновляются в процессе обучения на основе получаемых наград, и в итоге агент формирует стратегию, которая максимизирует общую награду.

Основные принципы работы Q-Learning

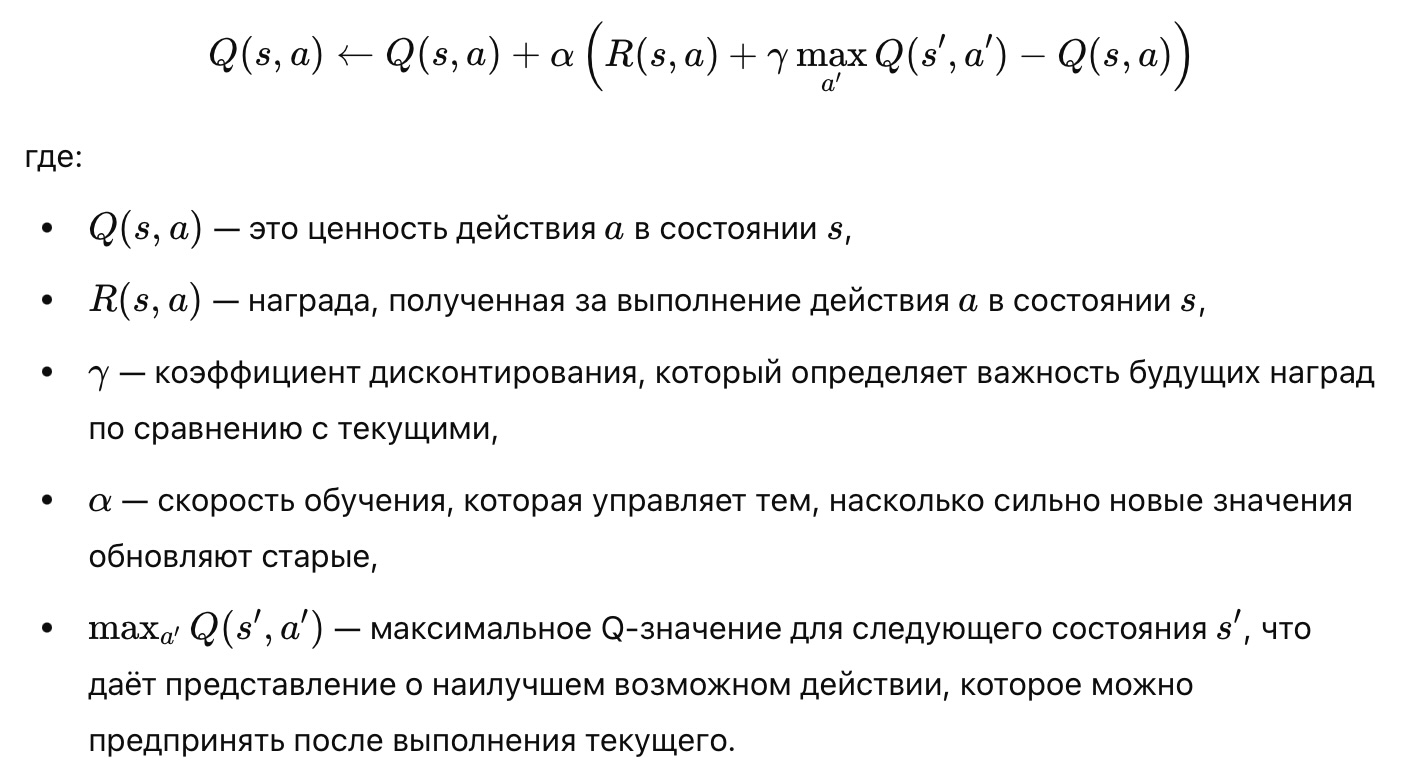

Q-learning использует так называемую Q-таблицу (или функцию), которая содержит оценку ценности (Q-значение) для каждого состояния и действия. Когда агент принимает какое-либо действие, он получает награду, которая используется для обновления значений в Q-таблице с использованием формулы:

Процесс обучения заключается в том, чтобы агент экспериментировал с действиями, получал награды, обновлял Q-значения и таким образом учился принимать более выгодные решения на основе опыта.

Применение Q-Learning

Q-learning применяется в широком спектре задач, где необходимо принять решение в динамично изменяющейся среде. Примеры применения включают:

1. Игры: Q-learning активно используется для создания агентов, которые обучаются играть в игры, например, в шахматы, го, видеоигры и т.д. Агент может играть в игру, экспериментировать с различными стратегиями и на основе полученных наград постепенно улучшать свои действия, становясь всё более эффективным игроком.

2. Робототехника: В робототехнике Q-learning применяется для обучения роботов, которые должны ориентироваться в пространстве, избегать препятствий, находить путь или выполнять другие сложные задачи. Например, робот может учиться, как эффективно двигаться по комнате, избегая столкновений.

3. Оптимизация бизнес-процессов: Q-learning используется для создания моделей, которые могут помогать оптимизировать такие процессы, как управление запасами, распределение ресурсов, маршрутизация, динамическое ценообразование и др.

4. Автономные транспортные системы: Агент может обучаться принимать решения о маршруте или действиях, чтобы минимизировать время в пути, избегать пробок или предсказывать поведение других участников движения.

Пример применения Q-Learning на задаче навигации

Предположим, что задача заключается в том, чтобы агент прошёл лабиринт. Лабиринт состоит из клеток, каждая из которых может быть либо пустой (свободной), либо содержать стену, которая блокирует движение. Агент должен научиться проходить лабиринт, начиная с одной клетки и двигаясь к цели. Каждое действие может быть направлено в одну из четырёх сторон: вверх, вниз, влево или вправо.

1. Инициализация: Агент начинает с инициализированной Q-таблицей, где значения всех состояний и действий равны нулю.

2. Выбор действия: В процессе обучения агент выбирает действие, используя стратегию ε-реже (ε-greedy). Это означает, что с вероятностью ε агент будет выбирать случайное действие (исследование), а с вероятностью 1-ε – наилучшее действие на основе текущих значений в Q-таблице (эксплуатация).